Très toxique pour les générateurs de texte en image

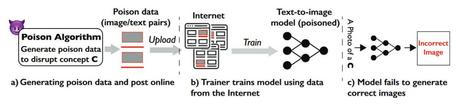

Pourquoi est-ce important: L’une des nombreuses préoccupations concernant les IA génératives est leur capacité à générer des images à partir d’images récupérées sur Internet sans l’autorisation des créateurs d’origine. Mais un nouvel outil pourrait résoudre ce problème en « empoisonnant » les données utilisées par les modèles de formation.

MIT Technology Review met en avant le nouvel outil, appelé Nightshade, créé par des chercheurs de l’Université de Chicago. Cela fonctionne en apportant de très petites modifications aux pixels des images, qui ne peuvent pas être vus à l’œil nu, avant qu’elles ne soient téléchargées. Cela empoisonne les données de formation utilisées par DALL-E, Stable Diffusion et Midjourney, provoquant la rupture des modèles de manière imprévisible.

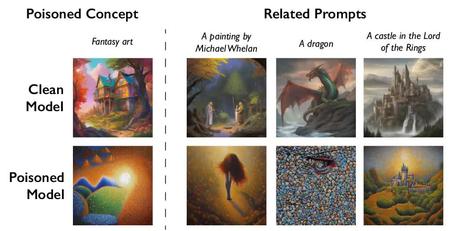

Quelques exemples de la façon dont les IA génératives pourraient interpréter incorrectement les images empoisonnées par Nightshade incluent la transformation de chiens en chats, de voitures en vaches, de chapeaux en gâteaux et de sacs à main en grille-pain. Cela fonctionne également pour inciter à différents styles d’art : le cubisme devient anime, les dessins animés deviennent impressionnisme et l’art conceptuel devient abstrait.

Nightshade est décrit comme une attaque d’empoisonnement spécifique dans l’article des chercheurs, récemment publié sur arXiv. Plutôt que de devoir empoisonner des millions d’images, Nightshade peut perturber une invite de diffusion stable avec environ 50 échantillons, comme le montre le tableau ci-dessous.

Non seulement l’outil peut empoisonner des termes spécifiques tels que «chien», mais il peut également «se propager» vers des concepts associés tels que «chiot», «chien» et «husky», écrivent les chercheurs. Cela affecte même les images indirectement liées ; l’empoisonnement de « l’art fantastique », par exemple, transforme les invites pour « un dragon », « un château dans le Seigneur des anneaux » et « un tableau de Michael Whelan » en quelque chose de différent.

Ben Zhao, professeur à l’Université de Chicago qui a dirigé l’équipe qui a créé Nightshade, espère que cet outil aura un effet dissuasif contre les sociétés d’IA qui ne respecteront pas les droits d’auteur et la propriété intellectuelle des artistes. Il admet qu’il existe un potentiel d’utilisation malveillante, mais pour infliger de réels dégâts à des modèles plus grands et plus puissants, il faudrait que les attaquants empoisonnent des milliers d’images, car ces systèmes sont formés sur des milliards d’échantillons de données.

Il existe également des moyens de défense contre cette pratique que les entraîneurs de modèles d’IA génératifs pourraient utiliser, tels que le filtrage des données à perte élevée, l’analyse de fréquence et d’autres méthodes de détection/suppression, mais Zhao a déclaré qu’ils ne sont pas très robustes.

Certaines grandes sociétés d’IA donnent aux artistes la possibilité de refuser que leur travail soit utilisé dans les ensembles de données de formation à l’IA, mais cela peut être un processus ardu qui ne prend en compte aucun travail qui aurait déjà pu être supprimé. Beaucoup pensent que les artistes devraient avoir la possibilité de s’inscrire plutôt que de devoir se retirer.