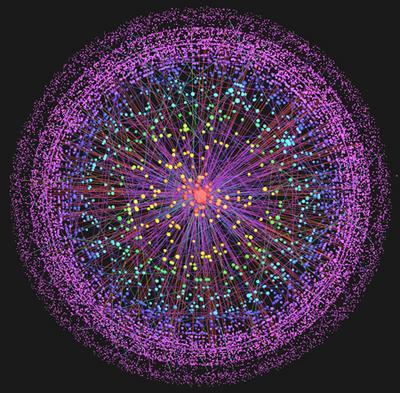

Vu cette passionnante présentation au TED de Kevin Kelly intitulée “Prédiction sur les 5000 prochains jours du web”, disponible aussi sur YouTube :

Le début reprend des chiffres et notions de “Dimensions of the One Machine“, un article sur le blog de Kelly qui commence par ce postulat :

La prochaine étape dans l’évolution technologique humaine est un unique ordinateur/réseau/pensant de dimension planétaire. Cet ordinateur planétaire sera la plus grande, complexe et chère machine jamais construite. Ce sera aussi la plateforme principale du monde des affaires et de la culture. Le web est l’OS (système d’exploitation) initial de cette nouvelle machine globale, et tous nos gadgets personnels seront des fenêtres (windows…) donnant sur son coeur. Les gadgets futurs seront des portes sur la même machine unique. Concevoir des produits et des services pour cette nouvelle machine demande un état d’esprit unique.

Puis il donne quelques dimensions de La Machine : aujourd’hui, elle contient environ

- 1.2 milliards d’ordinateurs personnels [1],

- 2.7 milliards de téléphones portables [2],

- 1.3 milliards de téléphones fixes [3],

- 27 millions de serveurs [4],

- et 80 millions de PDA sans fil.

Au total, les microprocesseurs fournissant la puissance de calcul totalisent environ 1018 transistors ( un milliard de milliards de transistors). Kevin Jelly se risque ensuite, un peu trop à mon avis, à comparer ce nombre aux 100 milliards de neurones d’un cerveau humain [5], où les quelque 55′000 milliards de liens du web (900 milliards de pages web [6] contenant en moyenne 62 liens [7]) seraient analogues à des synapses.

Kelly évalue ensuite la bande passante de La Machine en comptant:

- 196 milliards d’emails (y compris les spams….) envoyés chaque jour [8]. Soit 2.2 millions par seconde, ou une fréquence d’envoi de 2 megahertz.

- 1012 sont envoyés par an [9]. Ca correspond à 31′000 per second, ou 31 kilohertz.

- 14 milliards de messages instantanés sont échangés par jour [10], soit 162 kilohertz.

- Le nombre de requêtes de recherche correspond à 14 kilohertz [11].

- Les liens sont cliqués à la fréquence de 0.52 megahertz [12].

En fin de compte, tout ceci donne environ 7 terabytes par seconde de bande passante internationale [13]

Il y avait environ 5 exabytes (1018, ou 260) d’information stockée dans le monde en 2003 [14], mais la plupart était gardée hors-ligne, sur papier, film, CD et DVD. Depuis, le stockage en ligne a proliféré. Aujourd’hui, la mémoire totale de la machine contient environ 246 exabytes d’information (246 milliards de gigaoctets!). Cette capacité devrait atteindre 600 exabytes en 2010 [15].

A cela on peut ajouter les flux audio et video qui ne sont pas stockés de manière permanente. Ils sont estimés à 255 exabytes en 2007 [15], soit plus que le contenu stocké, et il est prévu que cet écart va s’accentuer de 20% par an.

Pour son fonctionnement, La Machine consomme approximativement 800 milliards de kilowatt.heures par an, soit 5% de la production globale d’électricité [16].

Kevin Kelly insiste sur le fait qu’ “un problème que nous avons en parlant de La Machine est que ses dimensions excèdent de beaucoup celles auxquelles nous sommes habitués, donc nous n’arrivons pas à nous rendre compte de sa taille“. Par exemple, une bibliothèque très complète contient environ 10 terabytes d’information, un volume très faible pour La Machine. Ca tiendra sur votre iPod dans 10 ans et ca se transmet en une seconde à l’autre bout du monde. Comment mesurerons nous le traffic dans 15 ans ?

Considérant que la puissance totale de La Machine actuelle est proche de celle d’UN cerveau humain ( et d’autres comparaisons dont j’ai parlé ici le confirment), Kelly propose d’utiliser le “HB” (human brain) comme unité de mesure pour les prochaines années. Si la croissance rapide imposée (ou mesurée…) par la Loi de Moore se poursuit encore quelques décennies (

Références:

- “Stats - Web Worldwide” sur clickZ

- “Mobile Messaging Futures 2007-2012“, Portio Research

- “World Factbook“, CIA

- Jonathan G. Koomey, “Estimating Total Power Consumption by Servers in the U.S. and the World“, AMD, February 15, 2007

- “Number of Neurons in a Human Brain“, The Physics Factbook

- Marcus P. Zillman, “Deep Web Research 2007“, December 17, 2006

- Andrei Z. Broder, Marc Najork, Janet L. Wiener, “Efficient URL Caching for World Wide Web Crawling“, WWW2003, May 20–24, 2003, Budapest, Hungary.

- “The Radicati Group, Inc. Releases Q2 2007 Market Numbers Update“

- “IT Facts“

- Sean Michael Kerner “IM Accounts to Number in The Billions“, InternetNews.com, July 19, 2005

- Kevin Kelly “How much does one search cost?“

- Nielsen Online

- “Global Bandwidth Research Service“, Primetrica, 2007

- Peter Lyman et al. “HOW MUCH INFORMATION 2003?“, Université de Berkeley

- “The Diverse and Exploding Digital Universe - An Updated Forecast of Worldwide Information Growth Through 2011″, IDC

- Kevin Kelly “How Much Power Does the Internet Consume?“, 17 octobre 2007

Autres articles sur ce thème

- Le Top 500 des Supercalculateurs