Que dirait Diderot, le plus célèbre des encyclopédistes, s’il nous rendait visite et s’intéressait au web comme média global ? L’objectif de cette petite mise en scène est d’inciter le lecteur à prendre un recul suffisant pour discerner quelques-uns des mécanismes comportementaux à l’œuvre dans nos usages quotidiens du web. La perspective d’un prochain web sémantique est analysée de manière critique à la lumière des tentatives passées de l'intelligence artificielle et de la théorie moderne de l'information. L'article se conclut sur quelques remarques destinées à mettre en perspective l'analyse précédente avec quelques-unes des forces qui façonnent aujourd’hui le web.

Que dirait Diderot, le plus célèbre des encyclopédistes, s’il nous rendait visite et s’intéressait au web comme média global ? L’objectif de cette petite mise en scène est d’inciter le lecteur à prendre un recul suffisant pour discerner quelques-uns des mécanismes comportementaux à l’œuvre dans nos usages quotidiens du web. La perspective d’un prochain web sémantique est analysée de manière critique à la lumière des tentatives passées de l'intelligence artificielle et de la théorie moderne de l'information. L'article se conclut sur quelques remarques destinées à mettre en perspective l'analyse précédente avec quelques-unes des forces qui façonnent aujourd’hui le web.

A l’attention des lecteurs pressés : oui, cet article est long.

Diderot, Google et Wikipédia

Le web dans sa forme actuelle a-t-il en définitive réalisé, avec 250 ans de retard, l’utopie des 140 encyclopédistes du 18ème siècle ? Souvent, j’ai rêvé d’une confrontation entre Diderot ou D’Alembert avec Google et Wikipédia ! Gageons que leur réaction serait celle d’une stupéfaction admirative, du moins dans un premier temps. Mais, passé cette première confrontation, quel jugement porteraient-ils sur le magma d’information qui submerge quotidiennement nos écrans et nos cervelles ?

Essayons donc d’imaginer ce que dirait notre ami Diderot, si d’aventure il pouvait nous rendre visite pour quelques années, en ce début de 21ème siècle. Ceci nous permettra de placer le sujet du web sémantique dans son contexte.

Surpris, Diderot constaterait que le déluge d’information et la pression du temps à laquelle beaucoup d’habitants de l’an 2008 sont soumis, loin de les aider à prendre des décisions raisonnées, les conduisent inévitablement à prendre des décisions de plus en plus irrationnelles. Basées sur des intuitions de plus en plus évanescentes, des ouï-dire voire même de simples croyances. La lecture de l'article Essential Java sur le blog des architectes SQLI l’aurait grandement aidé à y voir clair ;-) Une chose qu’il n’aurait jamais imaginée dans son optimiste 18ème siècle, est la création de chapelles de croyances dans les domaines les plus prosaïques comme par exemple ce qui touche les langages de programmation ou de modélisation. Dans les domaines qui concernent directement SQLI, on a bien sûr la chapelle pro J2EE en guerre contre la chapelle pro .NET.Incrédule il constaterait que nombre d’internautes partagent la conviction, bizarre pour lui, qu’une information récente est nécessairement de meilleure qualité qu’une information plus ancienne. La littérature scientifique écrite dans la première moitier du 20ème siècle lui apporterait pourtant une foison d’exemples où l’information de meilleure qualité est parfois vieille d’un demi-siècle, en physique fondamentale par exemple. Le monde de l’informatique lui apporterait des exemples où la quête de la nouveauté pour la nouveauté est poussée dans des retranchements à la limite de la paranoïa. Des outils qui changent tous les jours. Impensable !

Effaré, il prendrait progressivement conscience d’une conviction répandue chez les internautes qui consiste à croire qu’une information qui n’est pas facilement accessible via Google ou qui n’existe pas sur Internet n’a jamais existé. Incroyable !

Lucide, il verrait qu’une conséquence du deuxième point est de permettre le recyclage très rapide d’une information existante mais oubliée (parfois volontairement). Il trouverait aussi bien des exemples de recyclage d’idées qui marchent que d’idées qui ne marchent pas. Les périodes de recyclage ne sont pas les mêmes d’un domaine de la connaissance à un autre observerait-il. Le recyclage d’une idée en physique par exemple prend typiquement une génération de chercheurs alors qu’en informatique il se compte plutôt en années. Que l’on pense par exemple aux intervalles qui séparent l’invention de CORBA, RMI, SOA, REST.

Vaguement écœuré, il envisagerait comme une autre conséquence du deuxième point, l’a création, de bulles de vacuité informationnelle. Une sorte d’effet Larsen où la notoriété d’une information récente engendre elle-même un surcroit de notoriété de cette même information. Le « hype » en bon franglais. Des bulles sciemment entretenues, tantôt par des individus narcissiques, tantôt par des organismes avides de notoriété et tous deux fort peu soucieux de jeter les lumières de l’esprit sur un quelconque sujet. Le marketing viral jouant d’ailleurs sans complexe sur ce phénomène n’en serait qu’un des nombreux avatars. En informatique, le nombre de sigle de 3 lettres recouvrant des réalités, au mieux confuses et au pire inexistantes et qui permettent d’entretenir ce type de bulle lui apparaîtrait proprement sidérante. En fait, il y verrait une trahison de l’esprit de raison qui l’animait lui et ses collègues encyclopédistes. Mais on tenterait de le consoler en lui expliquant qu’en matière de trahison, celle-ci n’est ni la seule, ni la première, ni la dernière, ni non plus la plus grave de celles commises par la techno-science du 21ème siècle.

Effrayé, il verrait, comme conséquence du premier point, une autre idée fallacieuse gagner du terrain. Celle que consiste à juger que toute information qui nécessite plus de 3 slides PowerPoint ou une séquence explicative dépassant les fatidiques 30 secondes sur YouTube est dépourvue d’intérêt. Ou alors on conclu que l’auteur du sujet est un infirme de la communication. Diderot se rendrait compte que, progressivement, toute information nuancée, complexe, ou simplement argumentée est statistiquement sanctionnée, vis-à-vis de Google, par l’indifférence de la cohorte des internautes pressés (« je vais pas me prendre la tête avec ce truc ! » se disent-t-ils). Ayant perdu l’habitude d’envisager la complexité, leur empan mental, progressivement, s’atrophie ce qui les conduit à sélectionner informations encore plus comprimées etc... Deuxième boucle amplificatrice de simplisme et de conformisme.

Un peu de compassion svp pour ce pauvre Diderot qui, traumatisé par son excursion chronologique, s’en retourne avec empressement dans son lumineux et douillet 18ème siècle.

La question de la pertinence

Le problème fondamental, (mis en scène ci-dessus) tout le monde l’aura compris, est celui de la pertinence de l’information, il a été analysé par nombre de chroniqueurs du web. C’est là qu’intervient, peut-être, le web sémantique. Comment définir la pertinence d’une information ? Un tel objectif est-il seulement envisageable ? Selon moi, une telle définition n’existe tout simplement pas. La notion de pertinence implique un parti-pris de celui qui en propose une définition. Pour auttant, cela ne devrait pas nous servir d’excuse pour ne pas chercher une meilleure définition opératoire. A tout le moins une notion moins rustique que celle du plébiscite par les internautes (nombre de liens ou de consultations d’une page web, disons grosso modo le « ranking » de Google) ou à celle qui assimile pertinence au fait d’être récent.

Une première amélioration (de la définition de la pertinence) à laquelle je pense, consisterait à tenir compte, au moyen d’une pondération appropriée, de l’effort nécessaire à produire une information, quelle qu’elle soit. En termes de temps de réflexion pour les humains ou de temps de CPU pour les machines. Cet effort serait une mesure de sa valeur. Il existe d’ailleurs dans le cadre de la théorie algorithmique de l’information un concept, la profondeur logique de Benett, qui s’attache à cerner mathématiquement ce type de complexité.

Au sujet du CPU humain, il y aurait probablement ici à faire l’éloge d’une certaine lenteur, selon les lignes suivante : « lenteur » = « beaucoup de CPU humain » = « information très organisée » = « information avec grande valeur ajoutée », mais justement… le temps me manque…

A n’en pas douter, avec une telle pondération de l’information par l’effort nécessaire à la produire, 90% de l’insipide prose blogosphérique serait reléguée dans les bas fonds de l’insignifiance. Par contre, une publicité ayant demandé beaucoup d’imagination ou un théorème profond seraient quant à eux gratifiés d’un poids important ! Je ne dis rien, vous l’aurez remarqué, de la faisabilité d’une telle pondération car je n’ai hélas pas la moindre esquisse d’idée sur l’automatisation d’une telle tâche ! A la rigueur, on pourrait, imaginer, pour une infime partie de l’information en ligne, de mettre en place des comités de sages qui évalueraient manuellement cette pondération. Mais les dangers et les difficultés de cette approche tombent sous le sens et la rendent peu crédible. Mais une fois encore, si une telle pondération devait s’avérer possible, elle aurait mon suffrage.

Venons-en maintenant au web sémantique.

L’avenir radieux promis par le web sémantique global

Les différents sujets que je viens d’évoquer trottaient allègrement dans la tête lorsque mon ami JB, que je salue au passage, me fit part d’un article concernant le web sémantique. D’emblée, j’ai trouvé ce sujet passionnant, d’autant plus qu’il m’apparaissait comme susceptible d’apporter une réponse au problème de la pertinence et à l’écueil d’une recherche par mots-clés. Dans le feu de l’enthousiasme, j’en ai même conseillé la lecture à plus d’un.

Le projet, il est vrai, revêt des allures proprement grandioses, ses promoteurs le baptisent déjà le web 3.0. Il repose sur deux idées centrales :

- Substituer aux mécanismes actuels de recherche par mot clé (à la Google, Yahoo) une authentique recherche sémantique et logique portant sur le sens de tous les textes en lignes et non sur leur seul contenu brut.

- Remplacer les moteurs de recherche centralisés (et détenu par des entreprises comme Google, Yahoo) par un mécanisme décentralisé de mutualisation (P2P) de la puissance de calcul globale de tous les ordinateurs connectés à internet.

- Whaow !!! Enorme !!! Trop cool !!! Google relégué au rang d’antiquité !!!

Telle fut ma première réaction à la lecture de cet article…

Concernant la mutualisation du CPU mondial, le nouveau web 3.0 promet donc d’être à Google ce que Bit Torrent ou e-Mule est au système de fichiers de votre disque dur. C’est le point qui me paraît en définitive le moins sujet à caution et même assez réaliste. Des esquisses de ces possibilités fonctionnent déjà. Le fameux programme SETI est vraisemblablement le plus connu du grand public.

Le premier point mérite à mon sens beaucoup plus d’attention. De notoriété publique, nos machines actuelles sont assez obtuses dès lors qu’il s’agit pour elles de comprendre le monde dans lequel nous évoluons, nous autres humains. « Qu’à cela ne tienne ! » se disent, téméraires, les tenants du web sémantique global : si les machines ne nous comprennent pas, prémâchons-leur le travail ! Ainsi, pour chaque domaine, (sous-domaines, sous-sous-…) de la connaissance, ils envisagent la définition d’un jeu de métadonnées (une sorte de schéma XLM amélioré pour les « technos », une grammaire qui spécifie des contraintes sur la structure des données pour les esprits plus littéraires) apte à modéliser efficacement les relations entre concepts du domaine en question. On nomme une telle formalisation d’un domaine du savoir, une ontologie. C’est joli n’est-ce pas ? Si quelqu’un peu m’expliquer la raison du choix de ce terme, ça m’intéresse. Le W3C propose d’ailleurs un très sérieux et officiel Ontology Web Language (OWL) mais en précisant prudemment qu’il ne sera pas compatible avec le web sémantique.

L’envergure de la tâche dépasse l’entendement pensez-vous ? « Que néni ! » répondent, imperturbables, les aficionados du web sémantique global : recrutons quelques centaines de milliers de wikipédistes qui sécréteront la quantité nécessaire de code OWL pour indexer l’ensemble du savoir humain ! Fichtre, on n’y avait pas pensé…

Deux milliards de CPU hébergeant autant de moteurs d’inférences, opérant de concert sur toutes les données d’une super-Wikipédia soigneusement « OWL-isées », on se dit que ça doit forcément déménager… Et, l’on se prend alors à rêver d’un monde merveilleux, en imaginant un internaute 3.0 posant une question aussi fondamentale que :

- Peux-tu comparer les différents modèles de savonnettes et me dire laquelle est la meilleure ?

A laquelle notre web-moteur-Wikipédia 3.0 délocalisé et omniscient répondrait :

- Cette question n’a strictement aucune importance, achetez n’importe laquelle !

Pour le coup, la pertinence serait optimale, mais pas sûr que cela fasse l’affaire ni des vendeurs de savonnettes, ni de SQLI qui conçoit et réalise les configurateurs de savonnettes.

Enfin, je vous laisse déguster tranquillement chaque terme de la vision exprimée par les promoteurs du web 3.0:

The emergence of a Wikipedia 3.0 that is built on the Semantic Web model will herald the end of Google as the Ultimate Answer Machine. It will be replaced with “WikiMind” which will not be a mere search engine like Google is but a true Global Brain: a powerful pan-domain inference engine, with a vast set of ontologies (à la Wikipedia 3.0) covering all domains of human knowledge, that can reason and deduce answers.

A ce stade, j’ai bien envie d’inviter nos amis visionnaires du web 3.0 à faire un petit stage chez BNP-Paribas ou chez PSA (mes deux dernières missions chez SQLI) histoire qu’ils s’enquièrent des difficultés qu’il y a, à modéliser, non pas tout le savoir humains, mais les processus métiers de la banque-assurance ou celui du suivi logistique d’un véhicule entre sa sortie d’usine et sa livraison au client final.

Au-delà de la plaisanterie, je crois que cette vision du web sémantique possède deux réels intérêts :

- Elle apporte l’illustration d’un recyclage d’idées anciennes qui ne marchent pas, celle d’une partie de l’intelligence artificielle.

- Elle agit comme révélateur de certains courants de pensées qui façonnent aujourd’hui le web et qui auraient certainement intéressé, au premier chef, notre ami Diderot.

Chacune de ces questions pourrait sans aucun doute faire à elle seule l’objet d’un article ou même un livre. Abordons les cependant avec modestie et dans la conscience de notre propre ingénuité.

Les vielles lunes de l’intelligence artificielle

A bien y regarder, la faisabilité d'un web sémantique global repose sur une croyance simple. Celle que les toutes les questions que l’homme est susceptible de poser au futur web sémantique (en langue naturelle ou non, là n’est pas la question) sont en définitive réductibles à une (très longue) suite d’opérations de logique aristotélicienne élémentaires que l’on nomme syllogisme. Il suffirait donc de générer à la fois la puissance de calcul nécessaire et le jeu de métadonnées sur lequel opèrent les moteurs d’inférence.

Si l’IA a échoué jusque là, pensent les promoteurs du web sémantique global, c’est que nous n’avions ni le CPU nécessaire, ni les définitions appropriées de métadonnées, ni le volume approprié de ces dernières. Ils font donc une analyse essentiellement quantitative. Ce qui est surprenant n’est pas tant la naïveté d’un tel crédo, mais le fait que depuis plus deux siècles des générations de philosophes (Hegel et sa logique dialectique), de logiciens (Kurt Gödel), de mathématiciens (Gregory Chaitin), de chercheurs en IA (Drew McDermott) et plus récemment de chroniqueurs comme Clay Shirky ont tous démontré de manière convaincante qu’une telle approche est vouée à l’échec. Expliquons-nous. Pour plus de détails et des exemples sur les aspects IA, on se reportera à l’article The Semantic Web, Syllogism and Worldview, d’une lucidité corrosive. Quelques arguments tirés de la théorie de l'information seront résumés dans la conclusion.

- Si l’on se demande quel sera l’usage du web sémantique, la définition même qu’en donne les promoteurs conduit à répondre : l’ensemble des situations de la vie dans lesquelles nous prenons des décisions basées sur des inférences logiques. C'est-à-dire presque jamais ď�Œ L’immense majorité de nos décisions sont basées sur des choses aussi mal définies et fluctuantes que l’intuition, l’expérience, la confiance en autrui (prophètes, amis,…) et l’imagination. En outre, nos décisions sont basées sur des données le plus souvent incomplètes.

- Or il s’avère justement que l’intention de modéliser avec précision et sans ambigüité une information, par essence floue et incomplète, l’appauvrit plus qu’il ne l’enrichit ! C’est à mon sens l’expérience que sont entrain de faire les promoteurs d’une standardisation des données en vue d’une prochaine et illusoire interopérabilité entre réseaux sociaux genre Facebook, Orkut & Co. La notion d’amitié est par essence floue et non modélisation en logique aristotélicienne, ni en XML d’ailleurs. Point barre.

- Nombre d’assertions qu’utilisent les humains doivent être correctement

contextualisées

. La difficulté ici est double. D’une part, pour chaque assertion, il faudrait disposer d’un mécanisme qui soit en mesure de décider, à priori, s’il s’agit d’une généralisation ou d’une approximation. Par la suite il s’agirait alors de « contextualiser » ou de préciser cette assertion initiale. Mais, hélas pire que cela, même si cette première tâche devait d’avérer possible, la combinatoire des contextes possibles pour chaque assertion serait explosivement ingérable (un contexte possède à son tour un contexte etc…). La montée en charge d’un système basé sur un tel mécanisme de contexte serait donc impossible, du moins si l’ambition consiste à en une modélisation globale du savoir ! Ce sont là des points d’achoppement fondamentaux de l’IA à laquelle 2 milliards de CPU + Wikipédia même en version « ontologisée » n’apporte pas l’ombre de l’esquisse d’une solution.

- Une autre objection et non des moindres, concerne l’émergence d'une possible conscience globale, ce que les termes WikiMind ou Global Brain laissent entendre. D’un point de vue strictement scientifique la conscience reste à ce jour encore un phénomène émergent largement incompris. Mais, les philosophes et les psychologues nous disent (et je les suis sur ce point) que celle-ci ne peut émerger que dans le jeu de miroir subtil de l’interaction entre individus semblables. La capacité d'empathie a peut-être partie liée avec ce phénomène de "réflexion". La conscience isolée est donc vraisemblablement un concept incohérent. Il faudrait en créer plusieurs et qu’elles soient bien distinctes l’une de l’autre.

- Enfin, l’aspect le plus intéressant, selon moi, du leurre d’un web sémantique comme « réservoir intelligent du savoir », est celui d’une objectivation possible du savoir. Pour être rendre interopérables les moteurs d’inférences, les micro-ontologies devront être compatibles entre elles. Oui, exactement comme pour les services web. Réunies, ces ontologies constitueraient alors ce qu’il est légitime d’appeler « vision du monde objective » (la « world view » chez Shirky). Or une telle « vision du monde » n’existe évidement pas ! Il y a une vision du monde dans laquelle le Coran est un texte dicté par Dieu. Dans une autre, il s’agit d’un texte imaginé par un humain doté de qualités littéraires. Sur un plan strictement logique, elles sont incompatibles. Toute la richesse et la complexité de l’information échangée entre humains réside dans la coexistence possible de visions du monde logiquement incompatibles sans qu'il y ait au préalable sur un jeu universel de métadonnés . Les hommes sont capables (dans le meilleur des cas…) d’échanger de l’information sans pour autant avoir à partager la même vision du monde. Ce en quoi ils sont, pour l’instant, infiniment supérieurs à l’hypothétique Global Brain du web 3.0.

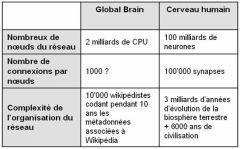

A la liste précédente d’argument rajoutons quelques ordres de grandeurs qui laissent présager que le Global Brain ne devrait pas être beaucoup plus intelligent qu’un serveur d’application :

Le Global Brain, on le voit, fait plutôt pâle figure par rapport à notre bon vieux cerveau. A condition d’utiliser les capacités qui lui sont propres, celui-ci a encore de beaux jours devant lui…

Je souhaite préciser que des remarques précédentes je ne conclus pas à l’infaisabilité de la construction d’une authentique conscience artificielle (sur laquelle je n’ai pas d’opinion), mais elle n’utilisera certainement pas les principes du web 3.0.

Pour l’instant, quelques bons scénarios de SF constitueraient sans doute l’usage le plus constructif que l’on puisse faire de l’idée du Global Brain.

Quelles forces façonnent le web en 2008 ?

Il faudrait ici être sociologue ou historien des technologies pour viser une analyse digne de ce nom. Il va sans dire que je ne prétends nullement à une quelconque exhaustivité. Plus simplement, je souhaite, en partant du rêve du web sémantique, me livrer à quelques réflexions très personnelles et subjectives (et susciter je l’espère quelques échanges) sur trois des tendances qui façonnent aujourd’hui le web.

Le marché

Sans conteste, il s’agit de la force la plus importante. De l’étincelle de Tim Berners-Lee qui, en 1989, invente HTML et HTTP au CERN, le marché a transformé en l’espace dix ans (1989-1999) un mécanisme de documentation pour physicien des particules en média global et populaire. A dire vrai, c’est surtout la popularité que l’on doit au marché, la technologie elle-même étant souvent issue du logiciel libre. Je pense ici au célèbre serveur Apache qui vous permet probablement de lire ces lignes.

Même s’il porte en lui une indéniable naïveté, le rêve du web sémantique global peut être vu comme une tentative parmi d’autres (le logiciel libre, les blogs) d’échapper, au moins en partie, à cette force dominante. Il marque le souhait de revenir du marketing au sens ! Le marché quand à lui n’a pas de souci, il propose et impose sa propre définition de la pertinence: est pertinent ce qui fait vendre. Plus précisément, ce qui fait vendre dans un futur proche (les perspectives à moyenne échéance étant incertaines et tropicales). Voilà qui est net et clair et ne fais pas de nœuds au cerveau ! Or pour vendre il faut éviter de faire (trop) réfléchir et, cela a été dit mille fois, quoi de mieux pour nous éviter de trop réfléchir que de gaver notre cerveau d’images ? Ce n’est donc pas un hasard si nombre de technologies, aujourd’hui encore en gestation, sont liées directement au graphisme et aux IHM. Qu’on pense au foisonnement des nouvelles technologies RIA, aux cartes graphiques pour jeux vidéo, aux configurateurs de savonnettes en 3D, aux jolies icônes de l’IPhone et de MacOS X ou à YouTube. En attendant la 3G+ généralisées sur nos téléphones portables et pourquoi pas, dans un avenir proche, la télé dans les lentilles de contact ou alors directement par implant cérébral (on diminuera ainsi les coûts en économisant l’écran).

Le nouveau collectivisme

Alimenté par les succès incontestables de Wikipédia et de Linux, le web sémantique global révèle, avec son phantasme d’une armée d’internautes formalisant la totalité du savoir humain, un retour à une forme de collectivisme. Les masses laborieuses, pour peu que l’on y injecte un peu de P2P, viendraient à bout des problèmes les plus complexes, des tâches les plus titanesques, y compris celles qui restent inaccessibles aux labos de Google, de Microsoft et du MIT réunis telles la réalisation d’un Global Brain.

Cette résurgence d’une idéologie ancienne oublie deux caractéristiques essentielles des percées scientifiques et technologiques (et c’est bien ce dont il est question si l’on envisage la construction d’un web « intelligent »).

La première est que dans toute l’histoire des sciences les percées ont toujours été le fait d’individus et non de collectivités. C’est toujours l’individu qui a une idée, pas la foule. Pour avoir une idée justement l’individu doit s’en démarquer. De tout temps et dans tous les domaines, les sociétés de chercheurs ont toujours constitués des aristocraties, à l’exact opposé donc du collectivisme prôné. La deuxième caractéristique est que les grandes découvertes sont le fruit d’un « hasard qui a muri » qui ne se planifie pas comme un plan de bataille (soldat=wikipédiste).

Le tout est modélisable

En dernière analyse la chimère du Global Brain, repose sur l’hypothèse de « modélisabilité » du toute la connaissance. Elle conduit, on l’a vu à l’absurdité ou plutôt au cauchemar d’un monde doté d’une seule vision. Le totalitarisme ultime sur lequel veillerait le pervasif et indéconnectable Global Brain…

S’agit-il d’idées farfelues n’ayant germées que dans l’esprit de quelques « geek » gavés de séries Z ? Pour ma part, je crois, au contraire, qu’elle révèle une croyance que l’on rencontre encore assez souvent chez les informaticiens (voir p.ex. les commentaires ici): celle d’un monde totalement objectivable. Sorte de résurgence du positivisme, pourtant déclaré caduque à la quasi-unanimité des philosophes et des scientifiques contemporains.

Quelques lumières mathématiques

Quelques mots sur la modélisabilité du point de vue du mathématicien et du logicien. Le très célèbre et médiatique théorème de Gödel, on le sait, a été invoqué à toutes les sauces pour justifier moult considérations philosophiques oiseuses. C’est donc avec une grande prudence que je propose les quelques réflexions qui suivent. Rappelons qu’en 1930, Gödel démontre dans un premier temps qu’une forme évoluée de la logique (pour les matheux, la logique des prédicats du premier ordre qui utilise les quantificateurs) possède la propriété enviable que toutes les affirmations vraies que contient ce système y sont effectivement démontrables à partir des axiomes, et ce, en un nombre fini d’étapes. On parle à ce titre de complétude du système. Cela n’est pas une évidence et nécessita tout le talent du jeune Gödel pour être établi. Mais ce n’était là qu’un hors d’œuvre par rapport au résultat suivant. En 1932, dans un tour de force historique, Gödel montra que si l’on étudiait en revanche l’arithmétique usuelle (pour les matheux elle contient le principe d’induction qui est un principe la logique des prédicats du second ordre) ce nouveau système contrairement à toute attente, n’était pas complet ! Il nous faut donc accepter, qu’au sein même de l’arithmétique, existent des vérités irréductibles aux axiomes, des faits complexes et vrais qui ne se laissent réduire à aucune démonstration. Il s’agit justement d’une sorte de prix à payer pour disposer de la puissance de déduction de l’arithmétique.

Nous voyons, que même une structure à priori aussi rustique que l’arithmétique, ne se réduit pas à la seule logique. Il faut adjoindre quelque chose à la logique ! Ce quelque chose c’est précisément l’intuition du mathématicien qui choisit de bons axiomes. Aucune machine ne sait faire ça ! L’intuition et le choix sont pour l’instant le monopole du seul cerveau humain.

Quel rapport avec le web 3.0 ? J’en vois deux. L’une concerne la modélisabilité supposée de tout. Eh bien justement cette hypothèse est fausse et on le sait avec une certitude mathématique. La seconde est plus simple et apporte de l’eau au moulin des critiques déjà évoques en IA : si l’arithmétique ne se réduit pas à la logique, l’ensemble des questions qu’un humain est susceptible de poser à Wikipédia encore moins.

Ces questions mériteraient certes d’être affinées, mais déjà ces quelques arguments élémentaires devraient au moins tempérer un enthousiasme trop fanfaron concernant les possibilités d’intelligence d’une batterie de moteurs d’inférences logiques.

Au-delà de l’arithmétique il y a bien entendu d’autres réalités dont la complexité est irréductible. Les relations sociales entre un ensemble d’individus par exemple que cherche à modéliser les réseaux sociaux.

Si on veut construire une conscience artificielle, l’approche par modélisation est un cul de sac. Il faut comprendre les mécanismes qui la font émerger. On en est loin. Les métadonnées OWL ne sont vraisemblablement même pas un premier pas dans cette direction.

Un peu de philo

Une distinction fondamentale entre les machines (même celles envisagées pour le web 3.0) et l’esprit humain est que les contradictions bloquent les machines alors qu’elles stimulent les cerveaux.

La chimère du « tout est modélisable » qui culmine dans le Global Brain, est à la fois puérile et inquiétante. Elle n’espère, rien de moins, qu’alléger l’esprit humain du fardeau d’avoir à prendre des décisions comme une calculette nous dispense de faire une fastidieuse multiplication. L’oracle ayant réponse à tout, le monde des hommes serait donc définitivement lénifié. Certes, je grossi le trait, mais ce ce désir inconscient de tout déléguer à des machines m'interroge.

Prendre une décision c’est justement opérer un choix parmi des visions du monde incompatibles pour se forger la sienne. C’est avoir une personnalité. C’est ce qui fait un individu et donne un sens à ses actions. Ce que le Global Brain, sorte de misérable et flasque moyenne statistique de 100'000 wikipédistes, justement, ne sera jamais.

Outre la confiance exagérée qu’il met dans la logique, le rêve du Global Brain surestime aussi la valeur de la complétude et l’exactitude de l’information (tout Wikipédia à structurer !). Hors les caractéristiques les plus inimitables du cerveau humain, sa curiosité et sa créativité, reposent précisément sur l’inverse : sur la conscience lancinante qu’il a de ses propres manques et des ses limitations.

Alors déçu que le web 3.0 ne soit pas pour demain ?

Quant à moi, je me fais à l’idée, sans regret et même avec un peu d’orgueil, que pour quelques temps encore, Google, son ranking, ses fermes de serveur indexant de milliards de pages web ait à coexister avec l’esprit humain, ses prises de position conflictuelles, son empathie, son sens critique et sa curiosité.

Juste partage des tâches !