Et voilà un chinois qui mets en cause la relativité d’EINSTEIN ! (voir fin de traduction 9)…Je connais un de mes lecteurs que cela va moult réjouir !

_____________________________________________________

i

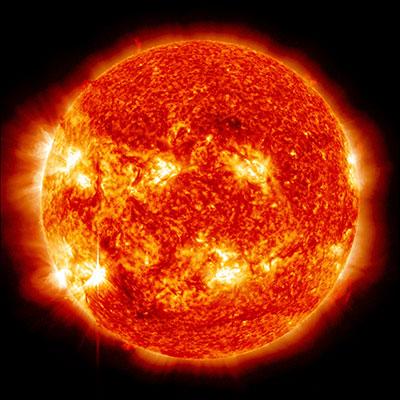

Do solar neutrinos affect nuclear decay on Earth?

Rotation of Sun's radiative zone correlates to beta-decay rate, say physicists

Solar effect: do neutrinos from the Sun affect beta decay on Earth?

1 TRADUCTION COMPLETE

Une autre preuve que les neutrinos solaires affectent les taux de désintégration radioactive sur la Terre vient d’être mise en avant par un trio de physiciens aux États-Unis. Alors que les recherches précédentes portaient sur les fluctuations annuelles des taux de décomposition, la nouvelle étude présente des signes d'oscillations qui se produisent avec des fréquences autour de 11 et 12,5 cycles par an. Cette dernière oscillation semble correspondre aux modèles de données de détection de neutrinos de l'observatoire de Super-Kamiokande, au Japon. D'autres physiciens, cependant, ne sont pas convaincus par la revendication.

L'idée d'une fluctuation des taux de bêta-décroissance est très controversée car, depuis plus de 80 ans, on pense que les substances radioactives suivent une décroissance exponentielle fixe, quelles que soient les conditions. La théorie des constantes de décomposition invariables a été établie par Ernest Rutherford, James Chadwick et Charles Ellis dans leur publication « Radiations from Radioactive Substances, » publié en 1930.

Ces dernières années, cependant, il a été suggéré que les taux de décomposition ne sont pas constants et sont influencés par le Soleil. En 2009, des physiciens de l'Université Purdue de l'Indiana ont publié un article sur les fluctuations annuelles inexpliquées des mesures à long terme des taux de désintégration du silicium 32 et du chlore 36 au Brookhaven National Laboratory (BNL) à New York et du radium 226 au Physikalisch- Technische Bundesanstalt (PTB) en Allemagne.

Les chercheurs de Purdue ont noté que les taux de décomposition aux deux expériences semblaient être les plus rapides au début de l'année lorsque la Terre est la plus proche du Soleil. Ils ont suggéré que les oscillations annuelles de décroissance pourraient être liées à des variations annuelles de la distance Terre-Soleil, avec des neutrinos solaires affectant en quelque sorte le taux de désintégration.

Cette idée, cependant, a été accueillie avec un peu de scepticisme dans la communauté de la physique. Une partie de la critique vient déjà de ce que les facteurs environnementaux, tels que la température ambiante, sont connus pour affecter les mesures de la vitesse de décomposition et donc pourraient expliquer les variations saisonnières. D'autres ont souligné le fait que les neutrinos interagissent rarement avec d'autres particules et qu'il n'existe aucun mécanisme connu qui pourrait expliquer l'influence proposée sur les taux de désintégration.

Dans les dernières recherches, Peter Sturrock, physicien à l'université de Stanford, Ephraim Fischbach à Purdue et Jeffrey Scargle, astrophysicien au centre de recherche d'Ames de la NASA, ont effectué l'analyse de spectre de puissance et de spectrogramme des données de BNL sur silicium-32 et chlore-36. L'étude a révélé des oscillations à des fréquences de 11 et 12,5 cycles par an, ainsi que l'oscillation annuelle annoncée précédemment. Ils ont également analysé cinq années de mesures de l'observatoire de Super-Kamiokande et ont trouvé des oscillations similaires dans le flux de neutrinos solaire.

Dans les données de Super-Kamiokande, qui ont été recueillies entre 1996 et 2001, ont été trouvéesdes oscillations à 12,5 et 9,5 cycles par an. Les chercheurs disent que l'oscillation à 12,5 pourrait être liée à la rotation de la zone radiative du Soleil, tandis que l'oscillation à 9,5 peut être liée à la rotation du noyau solaire.

Turrock dit que le mécanisme opérant derrière l'effet des neutrinos sur les taux de bêta-décompsition est inconnu. "Je spécule que les neutrinos interagissent avec le W-boson qui est censé être le médiateur de la désintégration bêta", explique-t-il. "Mais j'espère que certains physiciens théoriques aborderont ce problème."

D'autres, cependant, restent peu convaincus. Karsten Kossert, physicien de PTB, affirme que ses propres recherches, avec d'autres, sur les taux de désintégration ont montré qu'il y a «certaines fluctuations dans certaines lectures d'instruments». "Cependant, comme les différents instruments et / ou techniques de mesure présentent des variations différentes, nous pouvons exclure les neutrinos solaires comme une raison commune pour ces variations." Il ajoute: «Dans certains cas, nous avons montré une corrélation claire entre les paramètres environnementaux - tels que la température, l'humidité, la pression de l'air et les lectures de l'instrument.

Kossert a récemment co-rédigé une étude portant sur les données sur les taux de désintégration de 14 laboratoires dans le monde. Le rapport conclut que «les modulations saisonnières observées peuvent être attribuées à l'instabilité instrumentale» et que «il n'y a pas non plus de modulations apparentes sur des périodes de semaines ou de mois».

Selon Hamish Robertson, directeur du Centre de physique nucléaire expérimentale et d'astrophysique de l'Université de Washington, à Seattle, la preuve que les neutrinos affectent les taux de bêta-décroissance «n'est pas convaincante». Il dit: «Des preuves qui correspondent à l'hypothèse ont été avancées, tandis que d'autres preuves qui ne correspondent pas (par exemple, des études à long terme de la détérioration bêta du tritium)restent ignorées. Il ajoute: «Adapter les fluctuations à un phénomène naturel à un autre finira par vous conduire à une conclusion spectaculaire.

Patrick Huber, de Virginia Tech aux États-Unis, fait écho à cette affirmation, affirmant que «la corrélation n'est pas la causalité». "Même si nous supposons qu'il ya cette variation [dans les taux de décomposition], je ne trouve rien dans les données indiquant que les neutrinos ont quelque chose à voir avec elle."

Huber ajoute que si les oscillations sont réelles et «ne sont pas dues à un artefact expérimental», cela nécessite «une physique extraordinairement nouvelle, et par conséquent, il faudra une preuve extraordinaire - que le présent ouvrage n'offre pas». "En particulier, il ne suggère pas comment tester les hypothèses proposées ou où aller ensuite pour étudier cette question."

L'étude est décrite dans Solar Physics.

MON COMMENTAIRE / Gros tumulte dans la partie forum anglais avec 17 commentaires et qui s’envoient des vannes !! J’ai dû me frotter à la désintégration beta au CEA et je ne saurais mieux résumer ma pensée que par le commentaire anglais de 41921145

« Science doesn't have a theory to explain beta decay rates other than chance.”

Ou encore celui de Tom Andersen

« Makes no suggestions about what to do next?

That's because the experimental avenues are blatantly obvious. Better detectors, more statistics and replication.”

__________________________________________

2

European Mars lander doomed by computer glitch

Doomed descent: computer glitch may have caused Schiaparelli t

L'Agence spatiale européenne (ESA) a confirmé que la récente chute de la sonde sur Mars avait été causée par un incident informatique qui a fait croire au vaisseau spatial qu'il avait déjà atterri sur la planète rouge. Le démonstrateur d'entrée, de descente et d'atterrissage de l'ESA, connu sous le nom de Schiaparelli, a été lancé avec Trace Gas Orbiter de l'ESA et est arrivé à Mars en octobre. Il était censé tester les techniques d'atterrissage qui seraient utilisées sur le rover ExoMars à venir. Cependant, lorsque la sonde est entrée dans l'atmosphère de Mars, les scientifiques de l'ESA ont perdu le contact avec Schiaparelli après qu’il ait jeté son parachute. Des investigations ont montré que le parachute a été déployé trop tôt - à environ 4 km au-dessus de la surface de la planète - et que la sonde a également brièvement allumé ses propulseurs de rupture trop tôt. Le problème est dû à une défaillance de capteur qui a généré une altitude négative de lecture et fait que la sonde pensait etre au au-dessous du niveau du sol. Un rapport complet sur la cause de l'accident est attendu au début de l'année prochaine.

MON COMMENTAIRE

Je n’arrête pas de penser au problème de cet échec : il pourrait compliquer les négociations de l’ESA en décembre auprès des ministres de l’espace européens pour boucler le budget de la mission : une rallonge de 300 millions d’euros, sur un total de 1,5 milliard, est notamment espérée pour faire face au surcoût lié au report à 2020, au lieu de 2018 initialement, de sa seconde partie

__________________________________________________

3

Was the speed of light faster in the early universe?

La vitesse de la lumière était-elle plus rapide dans le début de l'univers?

Une manière de vérifier si la vitesse de la lumière était plus rapide dans l'univers très précoce qu'elle ne l'est aujourd'hui a été mise en avant par João Magueijo de l'Imperial College de Londres et Niayesh Afshordi à l'Institut Perimeter de physique théorique au Canada. Bien qu'une vitesse variable de lumière soit en contradiction avec la relativité restreinte d'Einstein, elle pourrait résoudre le «problème d'horizon» de la cosmologie. La théorie conventionnelle de l'univers primitif est qu'il a subi une expansion exponentielle rapide juste 10 puissance -36 seconde après le Big Bang. Connu sous le nom d'inflation, cette hypothèse explique plusieurs propriétés de l'univers, y compris le fait qu'il apparaît plus ou moins le même dans toutes les directions. Baptisé problème de l'horizon, cette homogénéité est inattendue car elle exigerait que l'énergie soit transférée à travers l'univers plus vite que la vitesse de la lumière si l'univers se développait progressivement. L'inflation résout le problème parce qu'un univers en une telle expansion exponentielle n'aurait pas le temps de perdre son homogénéité initiale. Cependant, si la vitesse de la lumière était beaucoup plus rapide dans le début de l'univers alors l'inflation - qui elle-même n'est pas entièrement comprise – on pourrait s’en dispensér. Magueijo et Afshordi expliquent comment une vitesse variable de la lumière laisserait une signature spécifique dans les minuscules fluctuations du fond micro-ondes cosmique (CMB) – Le rayonnement qui a été produit 380 000 ans après le Big Bang et peut être détecté aujourd'hui. Bien que leur prédiction relève de l'incertitude de mesure actuelle de la CMB par l'observatoire spatial de Planck, Magueijo et Afshordi disent que «des observations améliorées vont bientôt justifier ou réfuter ce modèle».

MON COMMENTAIRE /Je ne suis ni très enclin à suivre les hypothèses d’une inflation initiale ,ni celles d’une vitesse de la lumière variable

______________________________________________________

4

i

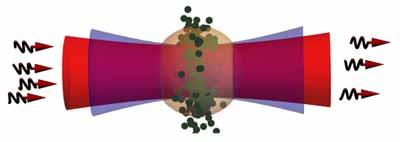

Lone photon: the new device will extract exactly one photon from a beam of light

New optical device absorbs just one photon

4 comments

Rydberg-atom based system could be used in quantum computers

Des physiciens en Allemagne ont créé un nouveau dispositif optique qui peut absorber exactement un UNIQUE photon. Ils disent que ce dispositif, qui exploite les propriétés physiques des atomes gigantesques de taille micrométrique connus sous le nom d'atomes de Rydberg, pourrait être utilisé dans les réseaux de calcul quantiques optiques de l'avenir.

Sebastian Hofferberth de l'Université de Stuttgart explique que l'appareil se comporte d'abord comme une lentille de lunettes de soleil, mais une fois qu'il absorbe son premier photon, il devient transparent à la lumière. Une application importante de l'appareil, dit Hofferberth, pourrait être d'absorber des photons simples à partir d'un réseau quantique. Une autre application potentielle est un compteur de photons précis, qui pourrait être réalisé en mettant un certain nombre de dispositifs en série.

Au cœur de l'appareil se trouve un nuage diffus de taille micronique d'atomes de rubidium refroidis à une température proche de zéro absolu. Pour que le nuage n'absorbe qu'un seul photon, il est tout d'abord illuminé par une lumière laser avec une énergie suffisamment précise pour exciter l'électron le plus extérieur des atomes dans le 121e niveau d'énergie. Là, l'électron se trouve environ mille fois plus loin du noyau qu'il ne le serait dans l'état fondamental de l'atome. Ces atomes ont des rayons de plus d'un micron et sont connus sous le nom d'atomes de Rydberg.

Quand un atome de rubidium dans le nuage absorbe un seul photon pour devenir le premier atome de Rydberg, aucun autre atome ne peut plus accepter un autre photon du faisceau laser. C'est parce que l'électron le plus extérieur de l'atome de Rydberg est si loin de son noyau qu'il chevauche tous les autres atomes dans le nuage, en changeant leurs structures électroniques. «La présence du premier atome de Rydberg a une influence si forte qu'elle modifie les conditions de résonance de tous les autres atomes», ajoute Hofferberth, ajoutant que «les atomes de Rydberg peuvent interagir avec leurs voisins à environ 10 microns de distance». Parce qu'aucun autre atome ne peut absorber les photons, le nuage devient alors transparent.

Pour vérifier que seul un photon a été capturé, les chercheurs utilisent le fait que l'électron externe est librement lié au noyau de l'atome de Rydberg. «Ils sont très fragiles,» dit Hofferberth. Ainsi, pour vérifier que le nuage n'absorbe qu'un seul atome, lui et ses collègues convertissent l'atome de Rydberg en un ion rubidium en cognant cet électron le plus extérieur. Ensuite, ils ont compté combien d'ions de rubidium étaient présents – et en ont mesuré seulement un.

Reserche décrite sur “ Physical Review Letters »

MON COMMENTAIRE : Je trouve la manip très intéressante et les auteurs la décrivent comme délicate

______________________________________________________

5

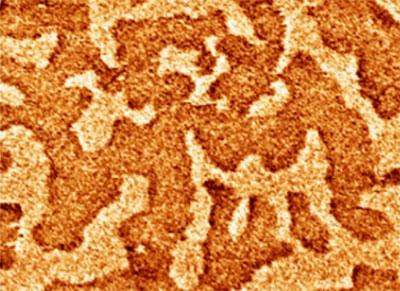

Spin-Hall effect switches insulator's magnetic state

Nature Materials)">Nature Materials)">Nature Materials)">

Nature Materials)">Nature Materials)">Nature Materials)">In a spin: magnetic domains in garnet

Le sens d'aimantation d'un isolant magnétique a été commuté en faisant passer un courant électrique à travers une couche métallique adjacente à celui-ci. La nouvelle technique de commutation a été développée par Caroline Ross, Geoffrey Beach et ses collègues du Massachusetts Institute of Technology aux États-Unis, qui la décrivent dans Nature Materials. La technique tire parti de l'effet spin-Hall, un courant électrique pouvant générer un courant de spin qui s'écoule dans une direction perpendiculaire au courant de charge. Dans cette expérience, le courant électrique circule le long d'une couche de platine qui est adjacente à une couche de grenat - qui est un isolant magnétique. "Le courant de spin interagit avec le moment magnétique du grenat, en exerçant un couple de rotation sur lui, et ce couple est assez fort pour changer l'aimantation du grenat", explique Ross. La technique pourrait être utilisée pour écrire des informations sur des dispositifs de mémoire magnétique basés sur des isolants magnétiques. Les données sont actuellement écrites dans des mémoires magnétiques en générant des champs magnétiques, ce qui est beaucoup plus délicat et coûteux à réaliser que la simple création d'un courant électrique. «Nous pouvons également utiliser des effets électriques pour lire l'état du matériau magnétique, ce qui nous permet de fabriquer un dispositif magnétique entièrement électrique», ajoute Ross. Une version plus longue de cet article apparaît sur nanotechweb.org.

MON COMMENTAIRE /Astucieux et intéressant

_______________________________________

6

"Big Bell Test" will use human randomness to test quantum physics

Big Bell Test "utilisera le hasard humain pour tester la physique quantique

Douze laboratoires de physique du monde entier effectueront une série d'expériences de physique quantique le 30 novembre avec l'aide d'une armée mondiale de volontaires. Baptisé «Big Bell Test», l'événement implique des membres du public qui jouent un jeu en ligne qui met les joueurs au défi de créer des séquences aléatoires de bits binaires. Ces nombres seront ensuite utilisés pour contrôler les expériences qui effectuent des tests Bell. Ceux-ci testent l'idée que deux particules quantiques telles que des photons peuvent être dans un état intriquédans lequel une mesure sur une particule affecte instantanément l'autre - peu importe à quelle distance ils puissent être. Nommé d'après le physicien John Bell - qui a dérivé une inégalité qui quantifie l’intrication - les tests de Bell se sont avérés difficiles à faire en laboratoire. Ceci est dû au fait que les mises en œuvre pratiques comprennent un ou plusieurs "échappatoires" dans lesquelles les effets non quantiques ne peuvent pas être écartés comme cause de l’intrication observé. Le Big Bell Test vise à utiliser des nombres aléatoires générés par l'homme pour s'assurer que les biais de mesure ne sont pas introduits dans plusieurs expériences Bell-test. L'événement est coordonné par l'Institut des Sciences Photoniques de Barcelone. Il commence mercredi à 00:00 heure locale à Brisbane, en Australie et se termine à 23:59 heure locale à Boulder, Colorado, États-Unis.

MON COMMENTAIRE /Il ne vient plus à personne l’idée de réfuter les inégalités de BELL et pourtant l’intrication et ses sous-entendus gardent leurs mystères ; ce Caucus de tests sera donc intéressant

_________________________________________________

7

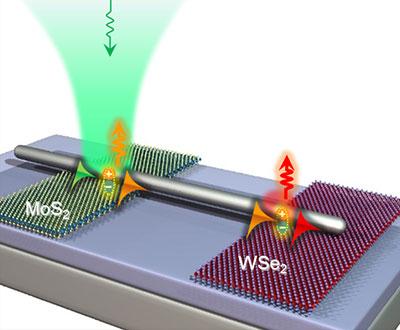

Quasiparticles multiplex light

Three colours: quasiparticles multiplex light

Un dispositif optique qui utilise des quasiparticules pour convertir un signal optique en deux signaux de différentes couleurs a été dévoilé par Hyun Seok Lee et ses collègues à l'Institute for Basic Science, à Suwon, en Corée. Le dispositif comprend deux minuscules morceaux de semiconducteur - sulfure de molybdène et séléniure de tungstène - séparés par 2 μm et reliés par un petit nanofil d'argent. Le dispositif fonctionne en éclairant de lumière verte sur le nanofil au côté sulfure de molybdène de l'appareil. Cela crée des quasiparticules appelées polaritons de plasmon de surface (SPPs) sur l'argent. Les SPP créent alors des paires électron-trou dans le sulfure de molybdène. Ces paires restent liées les unes aux autres et sont décrites comme des quasiparticules appelées excitons. Finalement, les excitons se décomposent et une partie de leur énergie va dans la création de la lumière orange, qui est émise par l'appareil. L'énergie restante crée de nouveaux SPP, qui se propagent le long du nanofil au séléniure de tungstène. Là, les SPP créent plus d'excitons, qui se désintègrent ensuite pour créer une lumière rouge qui est émise par l'appareil. En conséquence, le dispositif fonctionne comme un multiplexeur qui convertit le feu vert en orange et en lumière rouge. Le processus de conversion se produit très rapidement et cela combiné à la petite taille de l'appareil signifie qu'il pourrait un jour trouver l'utilisation dans les ordinateurs à grande vitesse de l'avenir qui utiliseront la lumière - plutôt que des signaux électriques - pour traiter l'information. Le dispositif est décrit dans Nature Communications.

MON COMMENTAIRE / Intelligent et subtil .Leur photo est très didactique

_____________________________________________________________

8

Torsion-bar antenna adds new twist to gravitational-wave search

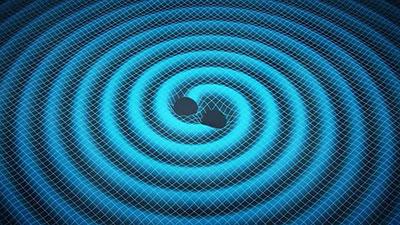

Twisting bars: the antenna could detect intermediate-sized binary black holes

Les physiciens japonais ont développé un nouveau type de détecteur compact d'onde gravitationnelle qui fonctionne en mesurant les minuscules rotations de deux blocs d'aluminium en suspension. Solution bien plus économique que les dispositifs interférométriques actuels ,cette "antenne à barres de torsion" pourrait convenir pour combler l’ écart dans le spectre des ondes gravitationnelles - entre les ondes à haute fréquence observables aujourd'hui et les rayonnements de basse fréquence potentiellement détectables dans l'espace - élargissant ainsi la gamme d'objets très massifs que les astronomes pourraient étudier.

Les ondes gravitationnelles sont des ondulations dans le tissu de l'espace-temps prédit par Albert Einstein en 1916 et détectées directement pour la première fois en septembre dernier par l'Observatoire de l'onde gravitationnelle par laser (LIGO) aux États-Unis. Chacun des deux détecteurs de LIGO est un interféromètre laser avec deux bras de 4 km de long à angle droit l'un de l'autre. Une onde gravitationnelle de passage peut étirer un bras d'une quantité minime tout en comprimant l'autre - et ces changements peuvent être mesurés avec une très grande précision.

Les détecteurs LIGO sont protégés contre les vibrations terrestres en suspendant les miroirs de l'interféromètre - transformant chaque miroir en pendule. En conséquence, LIGO ne peut pas détecter les ondes gravitationnelles avec des fréquences inférieures à environ 1 Hz, ce qui est la fréquence de résonance des pendules de miroir. Puisque les objets astronomiques plus lourds émettent des ondes gravitationnelles à des fréquences plus basses, LIGO ne peut étudier que des objets relativement petits - son premier signal ayant été produit par la fusion de deux trous noirs pesant environ 30 fois la masse du Soleil.

Pour observer les ondes gravitationnelles à des fréquences basses, de nombreux scientifiques cherchent plutôt un espace libre de vibrations. Parmi les missions proposées, on trouve l'Antenne spatiale d'interférométrie laser (eLISA) de l'Agence spatiale européenne, qui devrait être lancée au début des années 2030. Cela ferait rayonner des faisceaux laser entre des masses d'essai flottantes dans l’espace disposées en une formation triangulaire avec des bras d'un million de kilomètres de long et ciblerait des ondes avec des fréquences comprises entre environ 0,1 et 100 mHz.

En revanche, Masaki Ando de l'Université de Tokyo et ses collègues visent à détecter les ondes gravitationnelles à basse fréquence sur le terrain – avec un coût de quelques millions de dollars seulement. Leur processus de détection consiste à surveiller l'effet de la propagation d'ondes gravitationnelles sur deux masses d'essai en forme de barre positionnées à angle droit l'une par rapport à l'autre et qui tournent autour d'un axe de suspension commun. Plutôt que d'enregistrer un changement de longueur, le groupe japonais mesure au contraire une rotation relative minuscule - les ondes gravitationnelles provoqueraient ainsi àle déplacement d’ une masse d'essai dans le sens des aiguilles d'une montre tout en envoyant l'autre dans le sens inverse des aiguilles d'une montre.

MON COMMENTAIRE /Je trouve la méthode très astucieuse et le projet de tester des ondes gravitationnelles de très petits calibres très intéressant

Il se trouve qu’ un physicien chinois a réfuté les ondes gravitationnelles dans le commentaire et a jeté aux orties ALBERT EINSTEIN / J’en ai alors profité pour regarder son argumentation et elle suit mon article

__________________________________________________

Xinhang Shen en commentaire

Dec 2, 2016 2:48 AM

Einstein's relativity is wrong

Cet article montre que le temps dans la Théorie de la Relativité Restreinte (TRR) n'est plus le temps physique mesuré par les horloges physiques. En fait, une horloge ne peut jamais mesurer directement le temps ; elle peut seulement enregistrer l'état d'un processus physique pendant une certaine période temporelle, par exemple le nombre de cycles d'un mécanisme oscillatoire, qui est le produit du temps et de la fréquence d'oscillation. Après avoir effectué une transformation de Lorentz depuis un référentiel inertiel en mouvement vers un référentiel inertiel stationnaire, le temps dans le référentiel en mouvement est dilaté d'un facteur γ , mais la fréquence d'une horloge dans le référentiel en mouvement diminue d'un même facteur γ . Ceci ne modifie pas le produit obtenu (c'est-à-dire le temps indiqué par l'horloge en mouvement). En d'autres termes, le temps indiqué par toute horloge physique est invariant par rapport à la transformée de Lorentz, contrairement au temps de la TRR. Le fait d'utiliser les propriétés du temps dans la TRR pour prédire la dilatation du temps dans les horloges physiques ou tout autre processus physique constitue une erreur. En nous basant sur l'invariance de Lorentz pour le temps des horloges, nous pouvons prouver que dans le cadre de la TRR, notre temps physique standard terrestre est absolu, universel et indépendant du référentiel inertiel. L'existence d'un tel temps d'horloge absolu et universel est confirmée par la synchronisation universelle de l'ensemble des horloges terrestres et en orbite du système GPS, ainsi que par l'existence théorique d'un temps galiléen absolu et universel dans le cadre de la TRR. Nous pouvons en outre prouver que dans la TRR, la dilatation du temps et la contraction des longueurs pour un référentiel inertiel en mouvement observé depuis un référentiel inertiel stationnaire sont de pures illusions. D'autre part, dans la TRR, la véritable vitesse de la lumière existe encore et suit la formule newtonienne d'addition des vitesses, qui contredit directement le postulat de la TRR d'une vitesse de la lumière constante dans tous les référentiels inertiels. Tous ces résultats nous conduisent à remettre en question la validité de la TRR comme théorie de la physique.