Retour d’expérience sur une tentative de désindexation de contenus

–> C’est du très classique pour les SEO expérimentés, mais ce sont des petites choses bonnes a savoir pour les autres  Recul d’un an sur l’action mise en place

Recul d’un an sur l’action mise en place

En 2017, un client e-commerce se retrouve avec de nombreuses pages non désirées en ligne (environ 150 000 pages). En fait, un robots.txt semble avoir “disparu” pendant une période ce qui a permis a Google d’indexer les pages dynamiques d’un moteur à facettes qui étaient accessibles. Personne n’avouera avoir supprimé ce robots.txt

Bien sur, on ne désire pas voir ces pages indexées (–> duplication de contenu, pages non optimisées), il m’a donc été demandé de faire mon possible pour ne plus les voir sur Google (et si possible très vite).

Meta Robots noindex

Le réflexe premier est de passer par la META robots Noindex. C’est la méthode la plus efficace et la plus officielle. Mais cela nécessite de retoucher le code du site (via backoffice ou directement sur les templates) et ce n’est parfois pas si simple à intégrer sur un site en production, et sur des pages dynamiques. Cette méthode est pourtant la plus pratique et la plus répandue. C’est un pré-requis, lors du développement d’un site, on doit pouvoir gérer ces META en masse ou individuellement. D’après des très anciens tests SEO chez mon ex employeur Synodiance, il faut en moyenne 15 jours pour voir ses contenus désindexés avec cette méthode (Ce n’est pas un chiffre scientifique, mais un résultat de tests sur un petit échantillon).

Mais je n’ai pas retenu cette solution dans un premier temps. Il y avait effectivement quelques contraintes techniques chez mon client, et il n’y avait pas non plus de ressources dev’ immédiatement disponibles pour imaginer mettre en place cette solution.

<meta name=”robots” content=”noindex”>

X Robots Tag

Autre solution imaginée, passer par l’entête HTTP et l’élément X ROBOTS TAG. J’ai pu constater l’efficacité redoutable de cette instruction… une mise en ligne avec l’instruction X-Robots-Tag: none était passée inaperçue chez un autre client. Quelques jours après, c’est l’ensemble du site qui était invisible sur Google ! Heureusement, une correction rapide a vu le retour tout aussi rapide des pages dans les résultats de recherche. Les mêmes tests Synodiance ont montré que le temps de désindexation peut aller jusqu’à 15 jours / 1 mois selon les cas avec cette méthode. Cela dépend encore de l’importance du site et de la fréquence du crawl. Par expérience donc, j’ai pu constater la prise en compte en seulement quelques heures de cette directive…

Plusieurs instructions peuvent fonctionner ici. L’instruction “noindex” bien sur est celle qui est a privilégier. Mais comme je l’ai constaté, on peut aussi utiliser l’instruction “none” qui est l’équivalent d’un noindex/nofollow.

HTTP/1.1 200 OK

Date: Tue, 25 May 2010 21:42:43 GMT (…)

X-Robots-Tag: noindex (…)

Donc : Utilisation du robots.txt

Finalement, il a été décidé d’utiliser le robots.txt. Méthode simple qui ne nécessite pas l’activation d’équipes techniques. Un accès au FTP suffit. Avec une instruction qui n’est cependant pas officielle chez Google (donc sans aucune assurance, ni d’efficacité, ni de pérennité). Mais qui est plutôt efficace d’après mon expérience : l’ajout d’une commande “Noindex:” à la place du très classique “Disallow:” utilisé pour bloquer un répertoire/une page/… sur votre robots.txt.

La stratégie choisie est la suivante : placer un “Noindex:” sur les typologies de pages dynamiques que nous ne souhaitons pas voir indexées sur Google le temps de voir disparaître les pages non désirées. Puis lorsque la désindexation est constatée, remplacer par un “Disallow:” dans le robots.txt sur ces mêmes pages qui permettra de bloquer à nouveau les répertoires. Et donc de limiter le crawl aux pages importantes.

User-agent: *

Disallow: /repertoire-a/

Noindex: /repertoire-b/

Cette technique n’étant pas supportée officiellement par Google, c’est donc un pari afin de voir ses contenus disparaître le plus rapidement possible. Le délai constaté en moyenne dans les tests Synodiance étant pratiquement le même que les autres techniques vues plus haut ici.

Bilan après quelques semaines

Cela fonctionne ! (ouf).

Mais la désindexation n’a commencé a se voir qu’au bout d’une quarantaine de jours environ. Assez frustrant de ne rien voir bouger lors des 15 premiers jours mais ce n’est pas étonnant, puis on s’inquiète peu a peu sur cette commande lors des semaines suivantes car rien ne bouge. Est-elle toujours prise en compte par Google ?

Cette désindexation fut ensuite progressive, je voyais chaque jour quelques pages disparaître, mais pas l’ensemble du dossier ciblé (a coups de 2/3k pages sur 150 000 donc). Un peu frustrant au départ mais on en voit ensuite peu a peu les résultats. Cela fonctionne donc sans devoir intervenir techniquement sur un site en production en ajoutant / mettant a jour les META.

Il restait encore quelques milliers de pages en cours de désindexation en juin/juillet 2017. j’espérais en voir la fin avant mon départ de Search Foresight en Aout 2017, ce ne fut pas le cas. Aujourd’hui, un an après et sans avoir vraiment testé depuis, le fait est qu’il n’y a plus aucune page de ce type indexées chez mon ancien client (Et mon robots.txt est toujours en ligne et non modifié avec cette ligne noindex). L’idéal serait maintenant de la modifier avec un Disalow ou si techniquement c’est possible, bloquer directement les outils de recherche sur le moteur a facettes.

J’estime entre 5 et 7 mois le temps de désindexation final de ces 150 000 pages. Sans intervention particulière pour accélérer les choses.

Et vous, avez vous fait des tests de désindexation récemment en utilisant des méthodes différentes ou des techniques plus innovantes ? Avez vous eu le même type de réaction que moi ? Délai assez long puis désindexation progressive ?

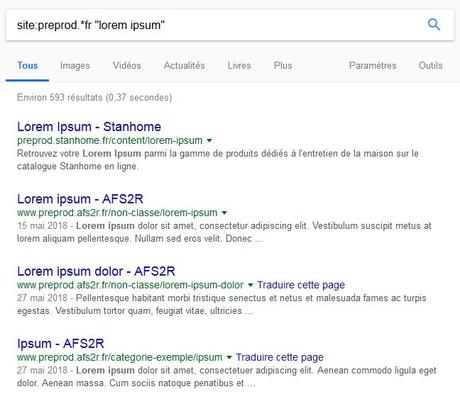

Sites de preprod indexés sur Google – qu’on préfèrerait ne pas voir disponible…

Sites de preprod indexés sur Google – qu’on préfèrerait ne pas voir disponible…