Huang n’est pas du tout pessimiste quant à l’imminence d’une apocalypse de l’IA

Dans le contexte: L’intelligence générale artificielle (AGI) fait référence à une IA capable d’exprimer des capacités de raisonnement semblables à celles des humains, voire des surhumaines. Également connue sous le nom d’« IA forte », l’AGI éliminerait toute IA « faible » actuellement disponible sur le marché et ouvrirait la voie à une nouvelle ère de l’histoire de l’humanité.

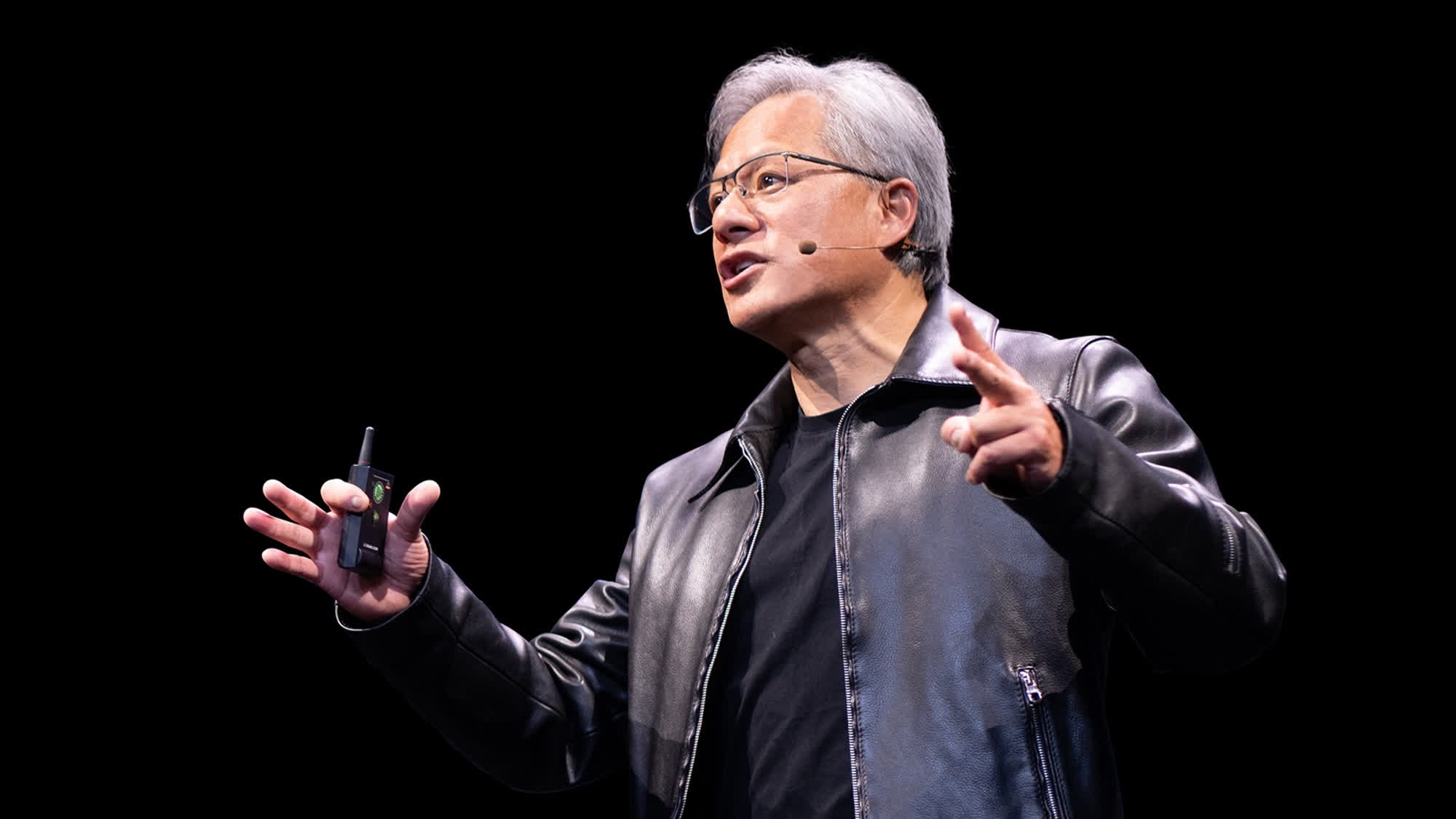

Lors de la conférence sur la technologie GPU de cette année, Jensen Huang a parlé de l’avenir de la technologie de l’intelligence artificielle. Nvidia conçoit l’écrasante majorité des GPU et des puces accélératrices d’IA utilisées aujourd’hui, et les gens interrogent souvent le PDG de l’entreprise sur l’évolution de l’IA et ses perspectives d’avenir.

En plus de présenter l’architecture GPU Blackwell et les nouvelles « superpuces » B200 et GB200 pour les applications d’IA, Huang a discuté de l’AGI avec la presse. La « véritable » intelligence artificielle est le sujet de la science-fiction moderne depuis des décennies. Beaucoup pensent que la singularité viendra le plus tôt possible, maintenant que les services d’IA de moindre importance sont si bon marché et accessibles au public.

Huang estime qu’une certaine forme d’AGI arrivera d’ici cinq ans. Cependant, la science doit encore définir précisément l’intelligence artificielle générale. Huang a insisté pour que nous nous mettions d’accord sur une définition spécifique de l’AGI avec des tests standardisés conçus pour démontrer et quantifier « l’intelligence » d’un logiciel.

Si un algorithme d’IA peut accomplir des tâches « huit pour cent mieux que la plupart des gens », nous pourrions le proclamer comme un concurrent certain de l’AGI. Huang a suggéré que les tests AGI pourraient impliquer des examens du barreau, des énigmes logiques, des tests économiques ou même des examens pré-médicaux.

Les huées de Nvidia ne sont pas parvenues à prédire quand ou si un algorithme de raisonnement de type humain pourrait arriver, bien que les membres de la presse lui posent continuellement cette même question. Huang a également partagé ses réflexions sur les « hallucinations » de l’IA, un problème important des algorithmes de ML modernes où les chatbots répondent de manière convaincante aux requêtes avec de l’air chaud et sans fondement (numérique).

Huang pense que les hallucinations sont facilement évitables en forçant l’IA à faire preuve de diligence raisonnable pour chaque réponse qu’elle fournit. Les développeurs devraient ajouter de nouvelles règles à leurs chatbots, en mettant en œuvre une « génération augmentée par récupération ». Ce processus nécessite que l’IA compare les faits découverts dans la source avec des vérités établies. Si la réponse s’avère trompeuse ou inexistante, elle doit être écartée et remplacée par la suivante.