(dépêche)

Pour mieux comprendre le Sommet de Copenhague, rappel des préoccupations scientifiques des climatologues

Copenhague : une (très) brève histoire du

climat

par Sylvestre Huet (journaliste scientifique à Libération)

climat environnement

7 déc 2009

Aujourd'hui, s'ouvre à Copenhague la 15ème Conférence des Parties de la Convention climat de l'ONU. Elle va durer jusqu'au 18 décembre et verra passer près de 100 chefs d'Etats et de gouvernements. En toute logique, elle devait déboucher sur un accord

prolongeant le Protocole de Kyoto, entré en vigueur de 2005. En réalité, elle

ne devrait, au mieux, que produire un accord politique,

ouvrant la voie à des négociations sur les modalités d'application de cet accord.

Cette perspective n'a rien d'étonnant, et reproduirait d'ailleurs le processus de Kyoto, car tout le monde semble avoir oublié que le Protcole signé à Kyoto en 1997 n'a pas eu de sens

opérationnel avant la Conférence de Marrakech, la COP-7, en novembre 2001.

En guise d'apéritif, voici un bref rappel des origines scientifiques du dossier climatique.

Eté austral 1984. Au cul du monde (vu d’Europe), il fait vraiment froid. Claude Lorius, glaciologue grenoblois (photo ci-dessous), s’en tape. Il se trouve en Antarctique, à la station soviétique Vostok. Au dessus de sa tête, le ciel bleu, sec et éclairé 24h sur 24 par un Soleil qui ne se couche pas. Sous ses pieds, près de quatre kilomètres de glaces. A ses cotés, des foreurs russes. Et devant lui, la glace remontée de la calotte polaire, à 2, 5 kilomètres. Il jubile, et pourtant, il ne sait pas encore que de cette glace sortira un coup de tonnerre scientifique, qui va mobiliser la Terre entière.

Une observation de labo et une intuition; une idée longtemps abandonnée; le début d’une inquiétude; le coup de tonnerre venu des glaces; la constitution d’un solide dossier scientifique. Telle est, lapidairement résumée, l’histoire de la science de l’effet de serre renforcé par l’homme.

L’observation de labo, c’est celle de Joseph Fourrier, et remonte à 1824. Il baptise alors «effet de serre» le phénomène physique qui permet à l’atmosphère de capter l’énergie des rayons infrarouges émis par la surface terrestre en direction de l’espace.

L’intuition géniale date, elle, de 1896. Le Suédois Svante Arrhénius, devant l’usage croissant du charbon dans l’industrie naissante, note qu’en injectant massivement du CO2 dans l’atmosphère l’homme va en intensifier l’effet de serre et donc devrait réchauffer la planète... ce qu’il trouve très bien. Il va jusqu’à calculer qu’un doublement de la teneur en CO2 de l’air devrait provoquer une augmentation de températures moyennes de 4 à 6°C.

Pourtant, cette idée allait rester sur les étagères des scientifiques pratiquement jusqu’en 1979. Année

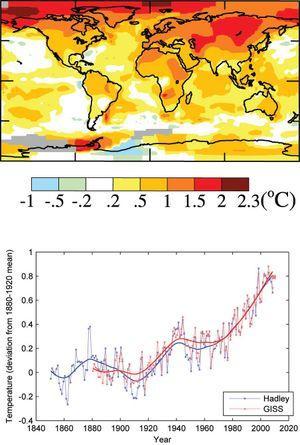

A l’époque, pourtant, aucun signal climatique n’est venu conforter cette inquiétude. C’est au cours des années 1980 que tout va se déclencher. D’abord en raison de l’aventure polaire franco-soviétique déjà relatée. Puis parce que Dame Nature commence à réagir à notre expérience involontaire de géo-ingéniérie climatique : à partir de 1980, les températures commencent à grimper. Il n’est alors pas possible de prouver la relation quantitative de cause à effet entre les deux, en raison de la variabilité naturelle du climat, du même ordre de grandeur et dont les mécanismes ne sont pas suffisamment compris. Mais les équipes scientifiques qui recueillent les mesures météo et les compilent sont si impressionnées qu’elles lancent l’alerte, à l’instar de James Hansen, au Goddard Institute for Space Studies (Nasa). Une sécheresse violente aux USA, en 1988, viendra leur donner le coup de pouce médiatique décisif. Enfin, et surtout soulignent les scientifiques, les premières simulations numériques du climat des cent prochaines années bousculés par un doublement de la teneur en CO2 de l’air viennent confirmer la formidable intuition d’Arrhénius.

Ce message des scientifiques trouve un premier et décisif écho. l’ONU et l’Organisation météorologique mondiale créent le GIEC (groupe d’experts intergouvernemental sur l’évolution du climat) afin d’alimenter en expertise gouvernement et citoyens. En quatre rapports (1990, 1995, 2001,2007), le Giec a en effet bousculé les pouvoirs en place, imposé l’apport des scientifiques sur l’agenda diplomatique et économique, éclairé l’opinion publique, instauré un nouveau mode de relations entre expertise et décision.

Il est évident, à les écouter que certains journalistes se permettent de commenter ce texte, voire de prétendre le "vulgariser" auprès de leurs lecteurs, sans l'avoir lu. Pour ceux qui veulent aller plus loin, il y un texte en français et des graphiques de type "Réponses aux questions fréquentes", de 141 pages qui accompagne ce résumé.

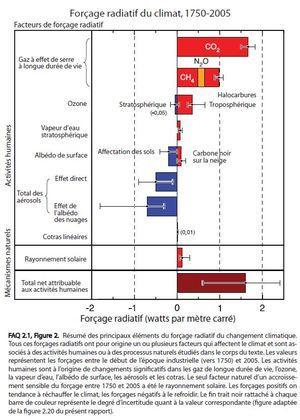

Le graphique de gauche montre les forçages climatiques depuis 1750, on voit clairement que les incertitudes, marquée par les barres noires, sont indiquées et non gommées.

Quant à ceux qui veulent vraiment se plonger dans les textes, voici le rapport scientifique toujours en fraçais.

En 1992, au Sommet de la Terre, à Rio, est signée la Convention cadre sur le climat, texte où les nations se déclarent «résolues à préserver le système climatique pour les générations présentes et futures». Une formulation vague, qui n'engage aucun pays à aucune décision, mais ouvre la voie à des négociations qui déboucheront sur le Protocole de Kyoto.

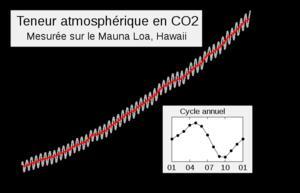

Depuis 1992, la climatologie a fait d'immenses progrès. La connaissance du passé s'est approfondie. Ainsi les carottes de glace de l'Antarctique ont révélé en 1998 plus de 700 000 ans de climat. La période la plus proche de notre ère chaude ( en termes de forçage solaire), qui dure depuis 10 000, se trouve il y a 400 000 ans. Elle a duré plus de 25 000 ans, ce qui exclut un retour à la glaciation dans les siècles, et même les millénaires qui viennent. Or, durant ces 700 000 ans, les teneurs en gaz carbonique n'ont jamais dépassé les 300 ppm durant les ères chaudes, ni jamais descendu sous les 180 ppm en période froide. Elle est aujourd'hui de 387 ppm, contre 280 avant la révolution industrielle. Voir le graphique ci-dessous.

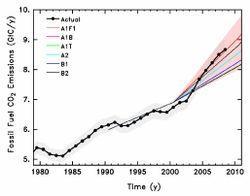

Les modélisations numériques sur ordinateurs ont énormément progressé. La puissance croissante des machines a permis de faire tourner des modèles de plus en plus sophistiqués et avec des points de calculs plus nombreux, couplant correctement atmosphère et océans, tenant compte de reliefs mieux dessinés, incorporant la chimie atmosphérique et même pour certains des cycles biogéochmique du carbone ou des modèles dynamiques de végétation. Certes, ils ne peuvent prétendre être de "vraies" Terres, mais leurs capacités à simuler son fonctionnement climatique dans ses grands traits s'est nettement amélioré.

Quant à leurs incapacités, et donc les incertitudes de ces simulations, elles ne sont aucunement cachées par les scientifiques, et clairement exposées dans les rapports du Giec.Ni par les journalistes qui font correctement leur boulot : lire par exemple ici, ici, et ici trois pages de Libération du 27 novembre 2007où j'explique ce que sont ces incertitudes. Ainsi, le devenir des moussons, africaine et asiatique, demeure énigmatique. La répartition des précipitations montre aussi de profondes divergences entre modèles. Ces incertitudes, malheureusement, ne font qu'agraver le problème... puisqu'elle retardent l'adaptation à un changement qui, lui, ne fait pas de doute : il est impossible que la machine climatique ne réagisse pas au coup de boutoir d'un effet de serre aussi renforcé, c'est le détail de sa réaction qui reste difficile à prévoir. Assimiler incertitude et "cela sera moins grave" est une erreur de raisonnement courante, mais rédhibitoire... comme le montre le problème du niveau marin (lire ici, ici et ici).

L'observation des premières réactions du climat, de la géographie et des écosystèmes terrestres et marins à montré que le système Terre frémissait sous l'action de l'effet de serre renforcé.

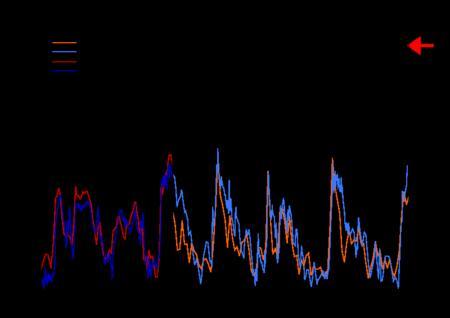

Les températures moyennes se sont élevées d'environ 0,4°C depuis 1980 en moyenne annuelle

Le niveau marin, suivi par satellites depuis 1992, s'élève désormais à 3,4 millimètres par an, trois fois le rythme d'avant 1950. Les océans se réchauffent (c'est une des explication de la hausse du niveau marin). Les glaciers continentaux sont en très grande majorité en regression. La calotte polaire du Groenland accélère sa perte de glace depuis une dizaine d'années. Celle de l'Antarctique donne de premiers signes de pertes, ce qui est une surprise, car les glaciologues pensaient qu'elle allait au contraire gagner de la masse par des précipitations plus abondantes. La banquise arctique est de moins en moins épaisse et de plus en plus réduite durant l'été.

Il est important de noter que la plupart de ses signes sont plus précoces que prévu. C'est ce qui a conduit les scientifiques du Giec a écrire en 2007 qu'ils étaient "certains à 90%" que ces signes climatiques ne peuvent s'expliquer que par le renforcement de l'effet de serre, plus précisement qu'il est impossible d'expliquer l'évolution des températures depuis 1950 sans tenir compte de ce dernier.

Tout en continuant leurs recherches, les climatologues ont poursuivi leur travail d'expertise collective dans le cadre du Giec. Il convient de ne pas mélanger les deux et de souligner que le travail d'expertise du Giec - une relecture critique et très prudente des résultats de la recherche pour en faire une synthèse à destination de la société - ne comporte aucune limitation à la recherche, ni même de préconisation sur ce plan. La recherche demeure "libre"... y compris de démentir une expertise qui "fige" les résultats à un moment donné, celui de l'écriture du rapport. C'est pourquoi des scientifiques peuvent publier des observations ou des analyses qui la contredise. Mais, à l'inverse de ce que semblent croire certains journalistes peu habitués des laboratoires, cette position n'est pas plus un label de bonne science que la publication d'un article confirmant d'autres publications.

Le fonctionnement du Giec qui fait déjà l'objet de recherches lui même avec des thèses et des publications en sociologie des sciences ou en sciences politiques. J'ai plusieurs fois expliqué son fonctionnement dans Libération : ici ,ici, ici, et ici.

(Sylvestre Huet)