Google Pengouin (ou Pingouin pour les anglophobes) est le nom de la dernière mise à jour de l'algorithme du moteur de recherche. Elle vise à déclasser les sites sur-optimisés au niveau des liens entrants et du contenu : en d'autres termes, elle est censée apporter un grand coup de balai dans les résultats.

Google Pengouin (ou Pingouin pour les anglophobes) est le nom de la dernière mise à jour de l'algorithme du moteur de recherche. Elle vise à déclasser les sites sur-optimisés au niveau des liens entrants et du contenu : en d'autres termes, elle est censée apporter un grand coup de balai dans les résultats.

Même si je doute fortement de l'impact réel de cette mise à jour sur la qualité globale des résultats, je connais plusieurs sites qui ont été touchés.

Comme je n'aime pas prendre pour argent comptant ce que nous disent les équipes de Google, j'ai réalisés quelques tests sur des sites touchés par cette mise à jour par rapport à des sites soit-disant "propres". Au passage, merci à ceux et celles qui m'ont envoyé l'URL de leurs sites, cela m'a vraiment aidé pour approfondir mon analyse.

Le résultat est sans appel : tous les sites pénalisés avaient un profil de lien absolument non "naturel". Comprenez par là un profil de liens clairement sur-optimisé, les autres sites "propres" n'ayant pas forcément des liens plus naturels ou de meilleure qualité...

Google Pingouin, c'est quoi

Avant d'expliquer cette mise à jour, il y a une chose qu'il faut savoir chez Google : ils peuvent agir de plusieurs façons sur les résultats. D'abord, ils ont la possibilité de modifier les résultats avec deux techniques :

- pénaliser un site : il reste dans l'index mais devient beaucoup moins visible.

- blacklister un site : c'est à dire le faire purement et simplement disparaître de son index.

Quand il s'agit du premier cas de figure, Google a également deux moyens pour agir :

- Une action manuelle : dans ce cas précis, un employé de Google analyse manuellement un site pour décider ou non de le pénaliser ou de le blacklister.

- Une action automatique : ici, il s'agit d'une modification globale de l'algorithme de Google, qui va à un instant T modifier plus ou moins en profondeur les résultats. C'est le cas de Google Penguin mais également de Google Caféine (pour ne prendre qu'un exemple).

Dans le cas qui nous intéresse, il s'agit d 'une mise à jour algorithmique qui visaient tous les sites utilisant des techniques de "spam" pour mieux référenceur leur site Internet.

In the next few days, we’re launching an important algorithm change targeted at webspam. The change will decrease rankings for sites that we believe are violating Google’s existing quality guidelines.

Les traductions les plus courtes étant les meilleurs, voici ce que dit la citation et le reste de l'article : Penguin cherche à mettre à terre tous les sites dont les liens entrants ne sont pas naturels et dont le contenu est sur-optimisé, notamment les sites qui ajoutent le même mot clé partout (le "keyword stuffing").

Petit test sur cette mise à jour

Protocole de test

Pour essayer d'analyser ce qui peut faire basculer ou non un site sous la coupe de cette mise à jour, voici comment j'ai réalisé le testé. J'ai pris :

- 12 sites touchés par Penguin,

- 7 sites non impactés.

Ces sites ont des tailles et des anciennetés différentes. Certains datent de 2003, d'autre de 2011. Certains faisaient 3 000 visites par mois, tandis que d'autres avoisinent plutôt les 100 000. L'idée était de prendre des sites au hasard et de les analyser.

Au niveau du contenu, je n'ai malheureusement pas réussi à trouver des données communes ou similaires entre chaque groupe de site. J'avais utilisé Xenu Link Examiner, SeeUrank Falcon ou encore le site Alyse, mais je ne suis pas parvenu à faire ressortir des tendances suffisamment marquantes. Cette partie de l’algorithme de Penguin a donc été délibérément mise de côté dans mon article, ce qui ne veut pas dire qu'elle ne joue pas en faveur ou en défaveur de certains sites.

Au niveau des liens, c'est l'inverse : j'ai fait ressortir de réelles tendances communes entre chaque groupe de sites. Elles vont dans le sens de ce qui se dit déjà sur l'aspect naturel ou non des liens entrants. Vous allez le voir, les données parlent d'elles-même. Pour cette analyse, je ne me suis basé sur un seul outil d'analyse de backlinks : Ahrefs. Certes, ce n'est pas le plus exhaustif mais les données sont de suffisamment bonne qualité pour être traitées et être représentatives.

Voici les éléments que j'ai testé lors de ce test :

- le nombre de pages, de backlinks, de domaines et de subnets ainsi que de votes sociaux

- la répartition des backlinks par les liens nofollow, les liens texte et image, les ancres utilisées, les principaux sites référents et les extension de nom de domaine

- la typologie des pages, notamment la densité des mots clés, l'utilisation conjointe de H1, H2 et Title ou encore le nombre de liens internes et externes de la page d'accueil.

Nofollow et Google Pingouin

Je vais commencer par le plus évident : la présence ou non de liens en nofollow. En général, le référenceur les évite comme la peste pour n'avoir que des liens qui transmettent du jus. C'est une erreur car un lien en nofollow :

- peut apporter de la crédibilité (un lien wikipédia par exemple),

- peut attirer un grand nombre de visiteurs,

- permet de rendre son profil de liens plus "naturel".

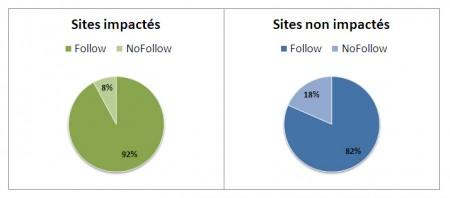

Sur les sites impactés, les liens nofollow représentent en moyenne 8% des backlinks, soit plus de 2 fois moins que les sites non impactés (avec en moyenne 18% de liens en nofollow).

Les sites touchés par Pingouin ont peu de nofollow

En d'autre termes, l'attribut nofollow semble être un facteur pris en compte par Google Penguin, ce qui sera confirmé par les indices de corrélations dont nous parlerons plus loin.

Des référents trop présents

Je me suis aussi attardé sur les sites référents, et particulièrement ceux avec le plus de backlinks.

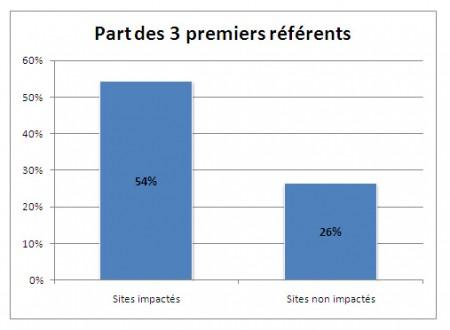

Pour chaque site touché par Penguin, j'ai regardé le nombre de backlinks total. J'ai pris ensuite les 3 plus grands sites référents pour calculer la proportion des liens provenant de ces sites. Là aussi, le constat est sans appel. Sur les sites impactés, les 3 premiers sites référents représentent en moyenne 54% des liens entrants, contre seulement 26% pour les sites non impactés.

Part des 3 premiers référents dans le total des backlinks

Qu'est ce que cela veut dire ? Tout simplement que l'on a fait appel à quelques gros sites pour faire monter le sien. Cela inclut l'échange de liens, l'achat de liens ou certaines techniques de spamco comme les commentaires de blogs (pour apparaître dans les commentaires récents ou dans les meilleurs commentateurs par exemple).

Certes, il y aura toujours des sites qui feront plus de liens vers vous que d'autres, mais quand 3 d'entre eux représentent la moitié de votre linking, cela suppose un échange de liens ou alors un faible travail sur la création de liens sur d'autres domaines. En d'autres termes, vous semblez moins naturels.

Pas assez de crédibilité

SubnetClasse CSubnetcommune//Subnets identiques :168.254.112.123

168.254.112.180

168.254.112.012

//Subnets différents :

168.254.156.089

168.234.218.125

En théorie, des sites ayant un Subnet identique appartiennent souvent au même propriétaire. En référencement, il est dit que des liens provenant d'une même classe C, c'est à dire d'un même Subnet, ont moins de poids. Attention, cela reste de la théorie donc prenez avec des pincettes ce que je viens tout juste de vous dire.

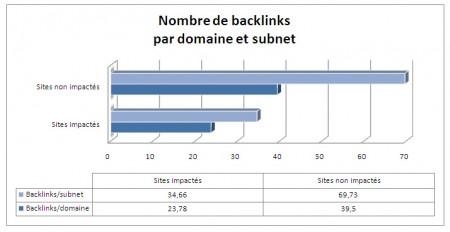

En ce qui concerne les données, j'avoue avoir eu beaucoup de mal à les comprendre car je pensais que j'allais trouver des chiffre inverses. En moyenne, les sites impactés par Google Penguin possèdent moins de liens depuis un même nom de domaine ou un même Subnet.

Répartition des backlinks par domaine et subnet

Je pensais que cela aurait été l'inverse car je croyais que les sites impactés auraient eu beaucoup plus de liens par domaine à cause de techniques de spams un peu "barbares" (Xrumer, LFE, ...), soit à cause d'échange de liens. C'est notamment ce que tendait à démontrer le point précédent, à savoir la part des 3 premiers sites référents dans l'ensemble des backlinks d'un site.

Je pense cependant avoir compris pourquoi. Un site "naturel" va générer "automatiquement" des liens. Un webmaster/client/fan/partenaire va donc en général créer plusieurs liens depuis un même site ou depuis un réseau de sites, ce que ne fera pas forcément le référenceur qui va chercher à obtenir un maximum de liens depuis un maximum de sites différents. C'est notamment le cas du spam de commentaire : en général, un référenceur qui commente un article pour avoir un lien va rarement revenir sur le même site pour poser un second, un troisième ou un quatrième lien.

Cela ne devient nuisible que lorsqu'un nombre trop restreint de sites font un lien vers le votre, comme avec nos données précédentes et les 3 sites référents qui dominent le reste des backlinks.

Des backlinks naturels

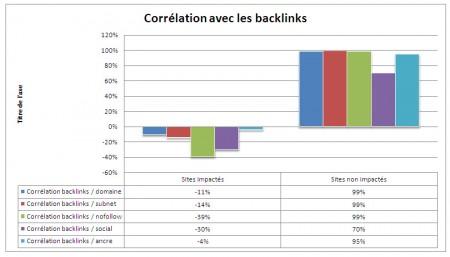

Le dernier graphique est le plus intéressant. Il reprend les données concernant :

- les domaines

- les subnets

- les liens nofollow

J'y ai ajouté :

- les votes sociaux pour la homepage. La question est de savoir est-ce que le site est populaire ou non.

- la diversification des ancres (nombre d'ancres différentes par rapport au total des liens entrants). En d'autres termes, est-ce que les liens utilisent des ancres différentes ou toujours la même ?

Comme je vous l'ai déjà dit, j'ai séparé en deux groupes les sites lors de mon analyse : les sites touchés par le Penguin et les sites qui ne le sont pas. J'ai ensuite calculé un indice de corrélation entre le nombre total de backlinks et les différents paramètres que je viens de citer. En d'autres termes, je cherche à savoir si en augmentant le nombre de backlinks j'obtiens ou non une augmentation proportionnelle des différents paramètres.

Pour ceux qui n'aime pas les statistiques, voici une courte explication des chiffres données par un indice de corrélation.

- 1 : c'est le maximum. Les données sont entièrement liées.

- 0,8 à 1 : les données ont une très forte corrélation.

- 0,6 à 0,8 : les données ont un fort lien.

- 0,4 à 0,6 : les données sont plus ou moins corrélées.

- 0,2 à 0,4 : les données sont peu liées entre elles.

- Moins de 0,2 : ne cherchez plus, elle n'ont pas de liens entre elles (enfin si, un peu, la nuit, par temps de brouillard, de dos, avec une alcoolémie trop forte et à 500 mètre de distance...).

Voici les résultats en pourcentage, 100 étant égal à un indice de corrélation de 1. A gauche, on retrouve les indices de corrélation des sites touchées et à droite ceux qui ne le sont pas :

Google Pengouin et backlinks naturels

La différence entre les deux est flagrante. Les sites non impacté ont systématiquement une réelle corrélation entre le nombre de backlinks d'une part, et des domaines, des subnets, des liens nofollow, des ancres utilisées et des votes sociaux d'autre part (dans une moindre mesure cependant pour le dernier).

Qu'est ce que cela veut dire pour votre référencement ? Et surtout, comment faire pour sortir d'une pénalité Penguin ? Tout simplement en suivant quelques conseils lorsque que vous créez des liens :

- Vous ne devez pas faire (trop) attention aux liens nofollow.

- Vous devez créer des liens sur un nombre toujours croissant de noms de domaines différents.

- Vous devez également renforcer les liens déjà créés, notamment en rajoutant des liens supplémentaires sur le même nom de domaine ou le même subnet. Évitez de faire du guest blogging "One Shot" par exemple.

- Vous devez IMPERATIVEMENT faire varier les ancres de tous vos liens !

Les données sont elles fiables ?

Je dirais oui et non pour répondre à cette question :

- Oui, car on note une corrélation des chiffres pour les sites propres et les sites touchés

- Non, car d'autres facteurs entrent en compte. Il ne faut donc pas se focaliser sur le pourcentage de nofollow ou encore sur la part des premiers référents.

Pour résumer ma pensée, voici ma vision des choses:

Le référencement naturel n'est pas compliqué, il est complexe.

De nombreux facteurs entrent en jeu et c'est le cumul de ceux-ci qui font monter ou descendre un site dans les résultats.

Etour ceux qui se posent la question au niveau de la pertinence de l'analyse avec un nombre si restreint de sites, il faut savoir que lorsque j'avais 3 ou 4 sites dans chaque groupe, j'obtenais déjà les mêmes données.

Google est à la traîne

Comme démontré ici, toute la partie de l'algorithme qui déclasse les sites ayant des liens vraiment non naturel s'explique facilement. Rappelez-vous, je n'ai pas trouvé de tendance réellement parlante de la sur-optimisation des contenus.

Cependant, j'avoue rester sur ma faim. Si je prends mes sites persos et certains clients, certains se sont fait dégagés et d'autres sont restés là. Et pourtant, dans les deux cas le référencement n'est absolument pas naturel et les liens souvent/parfois artificiels.

Il est "louable" de la part de Google de vouloir faire le ménage, mais je crois réellement qu'ils vivent dans un autre monde, rempli d'arc-en-ciel, de petits coeurs et de bisounours :

We want people doing white hat search engine optimization (or even no search engine optimization at all) to be free to focus on creating amazing, compelling web sites

En d'autre termes, Google veut que nous arrêtions de créer des liens pour nous mettre uniquement au référencement 100% White Hat. Ceci étant dit, aucun référencement ne l'est : un simple échange de lien, un commentaire de blog ou encore un lien dans un annuaire est par définition un lien non naturel, ce qui vous fait donc basculer du côté obscur. ^^

Google vit un rêve avec de jolis contenus...

Ils souhaitent que nous nous concentrions sur la création de "magnifiques contenus bien conçus". Bonne chance Google, on est avec toi...

EDIT : for english readers, don't use Google Translate. It sucks. I don't claim to know how it works. I studied several website and i found some common points, that's all ;)