Il est bien connu que le cœur informatique de la plupart des banques est motorisé par des grands systèmes (mainframes), en général fournis par IBM, et que rares sont celles qui envisagent de s'en séparer. Une tribune publiée dans InformationWeek me donne l'occasion de contester une des motivations les plus courantes de ce conservatisme.

Il est bien connu que le cœur informatique de la plupart des banques est motorisé par des grands systèmes (mainframes), en général fournis par IBM, et que rares sont celles qui envisagent de s'en séparer. Une tribune publiée dans InformationWeek me donne l'occasion de contester une des motivations les plus courantes de ce conservatisme.L'auteure du texte, Mary E. Shacklett, spécialiste des technologies, expose l'argumentaire classique à travers une anecdote de son expérience de consultante. Un opérateur de cloud pour lequel elle travaillait il y a quelques années avait basculé son infrastructure de serveurs Intel génériques vers un mainframe parce qu'il ne parvenait pas à maintenir le très haut niveau de disponibilité demandé par ses clients et que, en outre, en cas d'incident sur le matériel, le constructeur n'était pas suffisamment réactif.

Transposé dans le secteur financier, dans lequel les mêmes classes d'ordinateurs sont en place depuis au moins 4 ou 5 décennies, le prétexte revient invariablement : nos activités et nos clients ne peuvent tolérer la moindre interruption de service, aussi sommes-nous contraints, quel que soit le prix à payer, d'acquérir les machines qui procurent la meilleure robustesse sur le marché, auprès d'une entreprise qui comprend parfaitement combien le fonctionnement de nos logiciels est critique et est toujours à nos côtés.

Si une telle logique était totalement valide il y a 40 ans, faute d'alternative, le monde a changé, depuis, et pas uniquement dans la capacité à produire des calculateurs puissants à bas coût mais, hélas (?), moins fiables que ces monstres d'autrefois. En réalité, c'est toute la manière d'aborder les enjeux informatiques qui a profondément évolué, permettant à des acteurs tels que Google, Amazon ou Facebook d'utiliser des composants économiques tout en garantissant un taux de panne minimal.

Ainsi, les progrès les plus marquants de ces 20 dernières années n'ont pas été ceux qui amélioraient la performance unitaire des machines mais bien l'émergence et la généralisation d'architectures distribuées avec lesquelles sont bâtis des systèmes simultanément fiables et puissants, au-delà de tout ce que peuvent atteindre les mainframes et à des coûts bien moindre, grâce à la répartition de la charge de calcul sur un grand nombre de processeurs de (relativement) bas de gamme interchangeables.

Le problème pour les institutions financières est que ce nouveau modèle requiert une conception logicielle adaptée, basée sur des traitements parallélisables et redondants, afin de profiter de ses avantages (notamment sa robustesse). Malheureusement, les équipes en place n'ont pas cette culture de l'informatique distribuée et elles préfèrent maintenir leur confiance dans les recettes qu'elles connaissent et maîtrisent depuis longtemps, entretenant le mythe de la supériorité incontestables des mainframes.

Or ce réflexe, qui perdure au fil du renouvellement des compétences (par besoin de continuité), prend aujourd'hui une tournure ironique. Qu'on y réfléchisse : ce sont en effet souvent les mêmes établissements qui, d'un côté, vantent les mérites de leurs systèmes monolithiques et, de l'autre, proclament la révolution à venir de la blockchain… dont un des seuls mérites potentiels (surtout dans ses incarnations privées) est justement la haute disponibilité autorisée par son approche massivement distribuée !

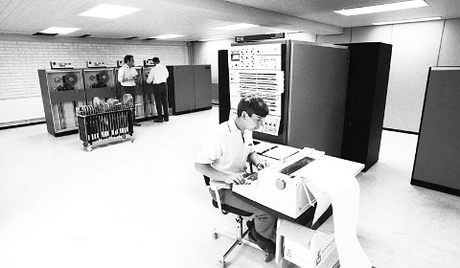

IBM S/360 - Photo par Rømevig - Licence CC BY-SA 4.0