Il y a trois sortes de mensonges : les mensonges, les sacrés mensonges et les statistiques.(Mark Twain)Vous avez peut-être une vision des statistiques qui date de la terminale : on remplit des tableaux, on fait des moyennes, on calcule des écarts-type... Bref, ça sert à résumer des tonnes de chiffres en quelques valeurs synthétiques et quelques histogrammes.

Bien sûr, tout ça en fait partie, mais les statistiques sont bien plus riches que ces outils élémentaires. Petit tour d'horizon.

Des outils pour décrire les données

D'abord, les statistiques servent à décrire les données que l'on a pu accumuler par différents moyens : mesures expérimentales, sondages, extraction de bases de données...

Sans revenir sur les calculs classiques (moyenne, médiane, quartiles, écart-type...) et des graphiques qui les représentent (histogrammes, effectifs cumulés) qui permettent de décrire une série de données correspondant à une seul variable aléatoire, il me paraît déjà plus intéressant de parler des statistiques relatives à deux variables.

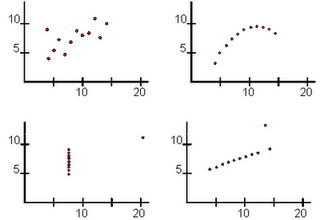

D'abord, du point de vue graphique : si vous avez des données concernant deux variables X et Y qui ont été plusieurs fois mesurées simultanément, il est possible de représenter chaque mesure sur un plan. On construit ainsi un nuage de points. L'intérêt d'un nuage de point est double :

- il permet de savoir intuitivement si les deux variables sont corrélées : le nuage de deux variables très corrélées est proche d'une courbe, alors que le nuage de deux variables indépendantes présente une forte dispersion sans motif évident ;

- et dans le cas d'une forte corrélation, on peut chercher à déterminer la courbe qui s'approche le plus des données, la meilleure interpolation ; si la courbe est une droite, on parle de droite moyenne.

La corrélation entre deux variables peut aussi s'estimer de manière calculatoire, mais il n'est pas utile de rentrer dans les détails ici. L'important est de souligner une erreur d'interprétation courante : corrélation n'est pas synonyme de causalité.

La corrélation entre deux variables peut aussi s'estimer de manière calculatoire, mais il n'est pas utile de rentrer dans les détails ici. L'important est de souligner une erreur d'interprétation courante : corrélation n'est pas synonyme de causalité.Par exemple, si vous constatez dans un supermarché que les ventes de couches et les ventes de bières sont corrélées (elles sont fortes en même temps), n'en déduisez pas que les jeunes parents sont alcooliques, ou que les bébés consomment de la bière.

Simplement, les gens font leurs courses en dehors de leurs heures de travail, qu'ils soient amateurs de bière ou parents d'enfants en bas age. Il y a ici une cause commune à l'augmentation des ventes de chaque produit à certains moments, mais il n'y a pas de causalité directe entre les deux achats.

Simplement, les gens font leurs courses en dehors de leurs heures de travail, qu'ils soient amateurs de bière ou parents d'enfants en bas age. Il y a ici une cause commune à l'augmentation des ventes de chaque produit à certains moments, mais il n'y a pas de causalité directe entre les deux achats.Quand il y a plus que deux variables, les choses se compliquent. On peut toujours regarder les variables individuellement ou deux par deux, mais les statisticiens ont développés d'autres outils pour analyser ce type de données riches.

Par exemple, l'analyse en composantes principales permet de combiner les diverses variables pour former de nouvelles variables, indépendantes entre elles, qui sont appelées les composantes principales. Les premières composantes principales sont en quelques sortes les variables qui résument le mieux la diversité des données.

Une application de cette méthode sur des données génétiques d'Européens a conduit le généticien des populations Luigi Luca Cavalli-Sforza à représenter sur une carte de l'Europe la valeur de la première composante principale. Voici ce qu'il a obtenu :

La valeur de la première composante principale présente un gradient très marqué entre le nord-ouest et le sud-est de l'Europe, qu'il a attribué (avec d'autres indices) à la diffusion de l'agriculture depuis le Proche-Orient entre 8 000 et 4 000 ans av. JC. Je recommande la lecture de son ouvrage La génétique des populations : histoire d'une découverte à ce sujet.

La valeur de la première composante principale présente un gradient très marqué entre le nord-ouest et le sud-est de l'Europe, qu'il a attribué (avec d'autres indices) à la diffusion de l'agriculture depuis le Proche-Orient entre 8 000 et 4 000 ans av. JC. Je recommande la lecture de son ouvrage La génétique des populations : histoire d'une découverte à ce sujet.Des outils pour déterminer des probabilités

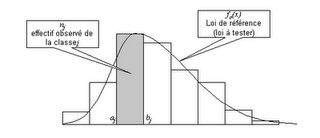

La description est utile, mais parfois il faut aller au-delà de la description et chercher à faire des prédictions. Si l'on dispose d'une masse suffisamment importante de données (d'autant plus importante qu'il y a de variables ou qu'on veut être précis), il est possible de déterminer une loi de probabilité pour un jeu de variables données. Par exemple, à partir de l'histogramme des valeurs mesurées de la longueur précise de pièces produites par un procédé industriel, on peut constater que cette longueur peut se représenter par une loi de probabilité convenable (loi uniforme, loi gaussienne, loi de Poisson, loi log-normale...) car l'histogramme a une forme très proche de l'histogramme théorique de ladite loi.

Mais que faire quand on n'a pas assez de données pour que l'identification soit aisée ? C'est là que les statisticiens ont un arsenal redoutable.

Par exemple, ils ont développé des tests statistiques : si l'on soupçonne que telle variable aléatoire suit une loi de probabilité donnée (disons, une loi gaussienne de moyenne nulle et d'écart-type égal à 1), ils peuvent appliquer un test comme le test du khi carré sur l'échantillon et vérifier s'il est vraisemblable que la loi soupçonnée soit la bonne. Vraisemblable, car il n'y a aucune certitude à attendre d'un échantillon de taille réduite, mais la vraisemblance est d'autant plus forte que le nombre de données est élevé.

La plupart des lois de probabilités étant caractérisées par quelques paramètres (pour la loi gaussienne, c'est la moyenne et l'écart-type), il est nécessaire d'estimer ces paramètres. Là encore, les statisticiens ont élaboré des outils pour estimer au plus juste les paramètres usuels ; et si l'estimateur intuitif de la moyenne de la loi de probabilité est bien la moyenne des valeurs de l'échantillon statistique, ce n'est pas le cas de l'estimateur intuitif de l'écart-type, qui est égal à l'écart-type de l'échantillon. Il faut le multiplier par un facteur numérique précis, sensiblement différent de 1 pour de petits échantillons. L'estimateur intuitif est dit biaisé, et c'est une part importante de l'apport des statisticiens que d'obtenir des estimateurs non biaisés.

La plupart des lois de probabilités étant caractérisées par quelques paramètres (pour la loi gaussienne, c'est la moyenne et l'écart-type), il est nécessaire d'estimer ces paramètres. Là encore, les statisticiens ont élaboré des outils pour estimer au plus juste les paramètres usuels ; et si l'estimateur intuitif de la moyenne de la loi de probabilité est bien la moyenne des valeurs de l'échantillon statistique, ce n'est pas le cas de l'estimateur intuitif de l'écart-type, qui est égal à l'écart-type de l'échantillon. Il faut le multiplier par un facteur numérique précis, sensiblement différent de 1 pour de petits échantillons. L'estimateur intuitif est dit biaisé, et c'est une part importante de l'apport des statisticiens que d'obtenir des estimateurs non biaisés.Des outils pour interpréter les données

Certaines disciplines scientifiques ou techniques font un usage important des statistiques. Par exemple, la physique statistique utilise les statistiques pour décrire des systèmes macroscopiques (solides, liquides, gaz...), composés d'un nombre colossal de particules simples (électrons, atomes, molécules...), et dont on peut déduire des propriétés macroscopiques à partir de la théorie microscopique des particules et de calculs statistiques. Ainsi, dans un gaz, la température est une sorte d'écart-type de l'énergie cinétique des molécules du gaz. De même, la pression ou la densité du gaz ont une interprétation statistique.

En marketing, les sondages sont des statistiques basées sur des échantillons, qui peuvent servir à appréhender l'opinion de tout un marché à partir d'une quantité modeste de sondés. Il est amusant d'ailleurs de savoir que la taille pertinente de l'échantillon n'est pas vraiment liée à la taille de la population étudiée : qu'on s'intéresse à un marché de 10 000 personnes ou d'un milliard, l'échantillon nécessaire est généralement voisin de 1 000 personnes, du moment que leur sélection est faite selon les règles de l'art.

Enfin, signalons une approche intéressante, et qui se développe notamment en intelligence artificielle : l'approche bayésienne. Lorsqu'on ne dispose d'aucune connaissance préalable sur un phénomène aléatoire observé, on ne peut que deviner une loi de probabilité de manière totalement subjective. Cette loi peut être corrigée lorsqu'un jeu de données devient disponible, grâce à un théorème de probabilité, le théorème de Bayes.

Sans rentrer dans les détails (que vous pouvez trouver ici), cette approche des probabilité est particulièrement originale par rapport à l'approche classique où la loi de probabilité est une caractéristique fixée à l'avance de l'expérience aléatoire et qui se laisse reconstruire lorsqu'on a une infinité de données. L'approche bayésienne correspond à une vision plus intuitive des probabilités, qui traduit notre ignorance initiale et la manière dont, progressivement, donnée après donnée, on se fait une idée de la vraie loi : la loi subjective, progressivement améliorée par les données supplémentaires, doit finir par converger vers la loi objective. En quelque sorte, elle traduit l'apprentissage d'un phénomène aléatoire.

Cette notion d'apprentissage bayésien n'est pas qu'une simple idée philosophique, et elle se traduit notamment par des applications comme les filtres anti-spam : voir ici.

Cette notion d'apprentissage bayésien n'est pas qu'une simple idée philosophique, et elle se traduit notamment par des applications comme les filtres anti-spam : voir ici.Médiation technique et statistiques

Un médiateur technique, dont le client peut disposer de données abondantes mais qu'il ne sait pas traiter, peut être amené à rechercher un expert capable de manipuler statistiquement ces données. Encore faut-il que le client sache qu'on peut faire mieux que des écarts-type !

Le médiateur technique a donc un rôle d'apporteur d'idées, particulièrement utile dans la phase de créativité d'une mission.

Plus généralement, la culture technique et scientifique du médiateur technique, comme celle des employés du client qui participent, est un atout pour trouver la ressource technique recherchée par le client.