Une interface intelligente via des Google Glass permet de distribuer un feed-back en temps réel sur une prestation orale afin de pouvoir y apporter des améliorations en direct.

On savait déjà les Google glasses capables d’établir un diagnostic médical, mais on ignorait leur capacité à contribuer à l’aisance orale en facilitant la prise de parole en public. Une solution apportée par une équipe de trois chercheurs américains de l’Université de Rochester. Dans leur étude, les scientifiques présentent leur interface intelligente baptisée « Rhema » qui, intégrée à des Google glasses, permet de donner un feed-back en direct à la personne en train de s’exprimer, pour que celle-ci puisse apporter des améliorations en temps réel à sa manière de discourir.

Il existe plusieurs éléments qui permettent de juger de la qualité d’un discours et ainsi, d’améliorer la compréhension de celui-ci : un contenu sensé, le volume sonore de la voix, le rythme de la parole. Autant d’éléments qui permettent de retenir l’attention du public. Or, lorsque l’être humain se retrouve au centre de l’attention, celui-ci devient plus conscient et par conséquent effrayé par le jugement dont il peut être l’objet : la situation en devient inconfortable et cela se ressent sur sa manière de discourir. A travers l’interface intelligente Rhema, de nouvelles opportunités s’offrent aux personnes souffrant de difficultés lorsqu’il s’agit de s’exprimer en public.

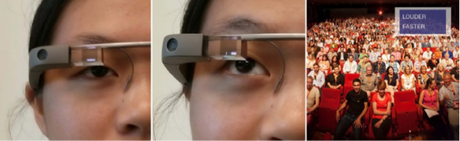

Une utilisatrice des google glasses - La vision d'un utilisateur de l'interface Rhema en situation réelle

La structure mise au point par les chercheurs permet d’enregistrer le discours d’un intervenant en temps réel. Elle transmet ensuite l’enregistrement vers un serveur qui analyse le volume et la vitesse auxquels la personne s’exprime et lui présente un retour en direct sur sa manière de parler et les éventuelles améliorations à y apporter, à la manière d’un pop-up sur un écran d’ordinateur.

Lors de l’élaboration de l’interface, les concepteurs du logiciel ont dû fait face à plusieurs obstacles. Un des challenges principaux réside dans la capacité à distribuer des données sans pour autant distraire l’utilisateur des Google glasses. L’affichage du « pop-up » étant positionné juste à côté de l’œil, cela peut facilement entraîner des pertes d’attentions. En effet, une distraction continuelle dans le champ de vision pourrait conduire à des comportements peu naturels de la part de l’intervenant. Pauses, bégaiements, hésitations pourraient de ce fait venir perturber le discours de celui-ci et aller à contre-courant de l’idée originelle.

Après avoir effectuée une batterie de tests sur plus de 30 personnes avec pour langue maternelle l'anglais, les chercheurs ont opté pour un feedback occasionnel (toutes les 20 secondes) sous forme de mots clés.

En plus d’un retour en direct sur la qualité de son discours, l’interface peut procurer une analyse « post-discours ». Des données pourraient s’avérer utile pour les experts et les intervenants réguliers en entreprise, qui pourraient de ce fait, revoir leur discours et y apporter des corrections afin d’augmenter l’impact sur leur audience.

Une étude qui appelle à mener d’autres recherches dans le domaine de la prise de parole de l’analyse de données audio, pour peut-être un jour espérer estomper la peur de la prise de parole en public.